Qu’est-ce que GPT-5.2-Codex ? En quoi diffère-t-il du GPT standard ?

Si GPT-5.2 est un Généraliste, alors GPT-5.2-Codex est un Spécialiste Conçu spécifiquement pour résoudre des problèmes de programmation complexes.

Selon Le dernier article de blog d'OpenAIGPT-5.2-Codex n'est pas simplement un modèle GPT standard affiné sur des données de code ; c'est le premier modèle architecturalement optimisé pour Ingénierie de bout en bout.

Principales différences par rapport à GPT standard :

- Persistance contextuelle : Les modèles GPT standard ont tendance à « oublier » les définitions précédentes lors de conversations longues. À l'inverse, Codex possède une mémoire ultra-longue. Fenêtre contextuelle Optimisé pour les bases de code, lui permettant de comprendre les dépendances entre fichiers.

- L'exécution, pas seulement la génération : GPT standard excelle dans l'écriture de « scissures de code », tandis que GPT-5.2-Codex est conçu pour comprendre un code complet. DépôtLors du lancement, Sam Altman a souligné que GPT-5.2-Codex n'est pas un simple outil de saisie automatique ; il fonctionne comme un ingénieur humain — lisant la documentation, localisant les fichiers d'erreur, écrivant des correctifs et réussissant les tests — permettant aux développeurs d'exécuter des tâches dans de véritables environnements de développement.

Points clés : Un double bond en avant en matière de données et de capacités

La publication de GPT-5.2-Codex a suscité d'importantes discussions au sein de la communauté technique, principalement axées sur trois domaines :

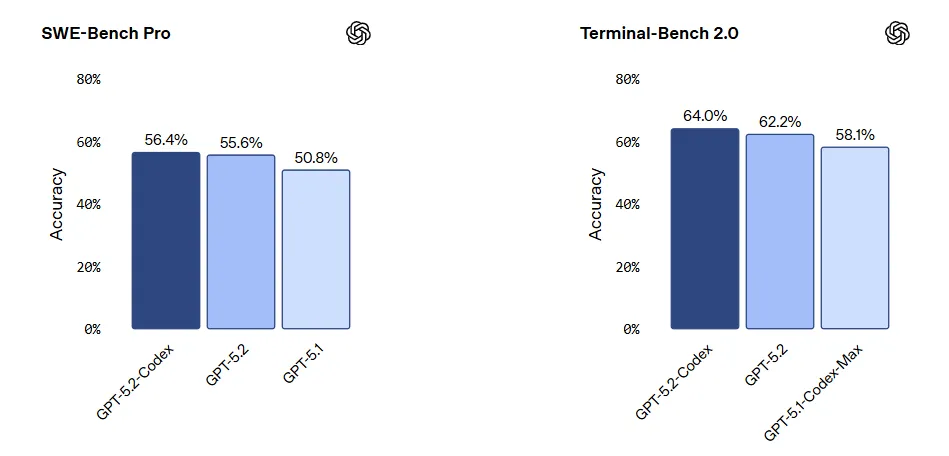

- Performances dominantes sur SWE-bench Pro : SWE-bench Pro est actuellement la référence en matière de mesure des performances de l'IA pour la résolution de problèmes GitHub concrets. GPT-5.2-Codex a réalisé un score historique (résolvant plus de 100 problèmes). 60% de problèmes), ce qui indique qu'elle est passée du stade du « Hello World » à la correction de bugs complexes en environnement de production.

- Boucle d'auto-amélioration : Selon Ars TechnicaOpenAI utilise en interne GPT-5.2-Codex pour générer des données d'entraînement et optimiser sa chaîne d'outils. Ce modèle d'amélioration récursive, basé sur l'entraînement de l'IA par l'IA, accélère les itérations au-delà des espérances humaines.

- Robustesse par carte système : La fiche système d'OpenAI révèle des améliorations significatives dans la gestion des « instructions ambiguës ». Lorsque les exigences ne sont pas claires, le modèle est moins sujet aux hallucinations et plus enclin à poser des questions de clarification ou à utiliser la déduction logique pour compléter le contexte.

Comparaison approfondie : GPT-5.2-Codex vs. Claude Code

Un sujet fréquemment débattu sur les réseaux sociaux est le suivant : « Lequel est le meilleur : GPT-5.2-Codex ou Claude Code ? »

Nous les comparons selon trois dimensions : données de référence, expérience utilisateur et cas d’utilisation.

| Dimension | Codex GPT-5.2 | Code Claude (3.5 Sonnet / Opus) |

| Performances du banc SWE | Niveau S Démontre une supériorité incontestable dans la résolution de bogues complexes impliquant des dépendances entre plusieurs fichiers. | Niveau A Les performances restent solides, même si elles rencontrent quelques difficultés avec les chaînes logiques très longues. |

| Expérience utilisateur | « La Bête Logique » Les utilisateurs font état de performances impeccables au niveau de l'architecture backend, de l'optimisation des algorithmes et de la logique mathématique, avec un minimum d'hallucinations. | « Plus humain » Les développeurs constatent généralement que Claude fait preuve d'une meilleure « intuition » pour l'interface utilisateur frontale, l'interaction en langage naturel et la génération de code en une seule étape. |

| Style de code | Rigoureux et conçu Tendance à générer un code de « qualité entreprise » comportant des commentaires détaillés et un strict respect des modèles de conception. | Concis et intuitif Génère un code très lisible, mieux adapté au prototypage rapide. |

| Intégration à l'écosystème | Écosystème robuste Intégration poussée avec GitHub Copilot et VS Code. | Grande flexibilité Il fonctionne exceptionnellement bien dans les éditeurs tiers comme Cursor et Windsurf. |

Verdict: Si votre objectif est refactorisation du backend, implémentation d'algorithmes ou conception de systèmes à grande échelleGPT-5.2-Codex est le choix évident. Si vous vous concentrez sur interaction frontale ou prototypage rapideClaude Code pourrait offrir une expérience supérieure.

Application pratique : Guide pour optimiser l'efficacité de la R&D avec GPT-5.2-Codex

Sur la base des capacités d'ingénierie de GPT-5.2-Codex, nous avons défini trois scénarios d'application principaux et des flux de travail standard au sein du cycle de vie moderne du développement logiciel (SDLC).

Scénario 1 : Refactorisation au niveau du système et migration de la pile technologique

Contexte de l'application : Gestion de la dette technique impliquant des modifications massives de fichiers, telles que des mises à niveau majeures du framework (par exemple, la migration des composants de classe React vers les Hooks), la standardisation de l'infrastructure (spécifications de journalisation, intégration de l'intergiciel de sécurité) et le nettoyage du code mort.

Flux de travail standard :

- Étape 1 : Contextualisation. Accordez à GPT-5.2-Codex un accès en lecture à l'intégralité du dépôt Git via des plugins IDE ou des outils d'intégration CI/CD pour établir un index de dépendances complet.

- Étape 2 : Définition des contraintes. Saisir les documents de proposition technique pour définir les limites de la refactorisation.

- Exemple de commande : « Maintenir la compatibilité ascendante avec les API V1. Toutes les opérations de base de données doivent passer par la couche ORM ; la concaténation SQL directe est interdite. »

- Prétraitement : Demandez au modèle de produire un Plan de refactorisation, en listant les modules concernés, les risques potentiels et les stratégies de restauration.

- Étape 3 : Exécution itérative et Revoir.

- Exécution: Le modèle soumet des demandes d'extraction par module.

- Vérification: Déclenchez le pipeline de tests automatisés (CI Pipeline) et renvoyez les journaux d'échec au modèle pour une correction automatique.

- Acceptation: Ce sont des ingénieurs humains qui effectuent la revue de code finale, en se concentrant sur la solidité de l'architecture plutôt que sur les détails de la syntaxe.

Scénario 2 : Développement en cycle complet et débogage automatisé

Contexte de l'application : Ce module couvre le développement des fonctionnalités et la correction des bugs, avec pour objectif de laisser l'IA gérer les détails d'implémentation pendant que les développeurs se concentrent sur l'orchestration logique.

Flux de travail réel :

- Développement de nouvelles fonctionnalités (TDD amélioré) :

- Décomposition: Saisissez le document de spécifications produit (PRD) et laissez le modèle le convertir en un document technique. Liste des tâches.

- Génération de code : Pour chaque tâche, demandez au modèle de générer de manière synchrone code d'implémentation métier et tests unitaires à couverture élevée.

- Correction de bogues (analyse des causes profondes) :

- Saisir: Fournissez les traces de pile complètes, les fragments de journal pertinents et les fichiers sources concernés.

- Analyse et correction : Le modèle effectue une analyse d'attribution inter-fichiers pour localiser le Cause première et génère un Correctif.

- Prévention de la régression : Obliger le modèle à rédiger des cas de tests de régression afin de garantir que la même erreur logique ne se reproduise pas.

Gain d'efficacité : Les développeurs passent d'une part importante de leurs efforts consacrée à l'implémentation du code à une autre axée sur… Clarification des exigences, Décisions architecturales, Examen des cas limites, et Revue de code.

Scénario 3 : Ingénierie front-end et génération de code d’interface utilisateur

Contexte de l'application : Convient pour la construction rapide d'un MVP (Produit Minimum Viable), le développement d'outils internes et le rendu haute fidélité de pages marketing.

Flux de travail standard :

Étape 1 : Analyse visuelle : Saisissez des captures d'écran ou des liens de prévisualisation de votre maquette Figma. GPT-5.2-Codex analyse la structure DOM, la hiérarchie des composants et les paramètres de mise en page.

Étape 2 : Génération de code :

- Couche de structure : Génère des squelettes de composants conformes aux normes du projet (par exemple, React/Vue/Next.js).

- Couche de présentation : Génère du CSS atomique (par exemple, Tailwind CSS) ou le code de bibliothèque d'interface utilisateur correspondant (par exemple, Chakra UI/Ant Design).

Étape 3 : Complétion logique : Les développeurs connectent les données de l'API backend et lient les événements d'interaction au code généré.

Gain d'efficacité : Réduit considérablement le temps passé à Code standard, permettant ainsi un flux semi-automatisé de la conception à l'implémentation front-end.

Considérations de sécurité et pratiques

Malgré ses puissantes fonctionnalités, la fiche système d'OpenAI émet des avertissements que les entreprises doivent prendre en compte lors de sa mise en œuvre :

- Excès de confiance : Face à des frameworks privés qu'il ne connaît pas, le modèle peut fournir avec assurance un code incorrect.

- Failles de sécurité : Bien qu'il ait fait l'objet de tests d'intrusion, il subsiste un risque de vulnérabilités par injection dans les requêtes SQL complexes ou les appels système.

- Meilleures pratiques : Maintenez toujours un « L’humain dans la boucle » Approche à privilégier : ne pas autoriser l’IA à déployer directement du code en production ; la revue de code manuelle demeure le dernier rempart.

Le déploiement de GPT-5.2-Codex marque un tournant structurel dans le génie logiciel. Avec l'automatisation croissante de l'implémentation traditionnelle du code, les compétences fondamentales du développeur seront redéfinies. Conception de l'architecture système et Production techniqueCela signifie que les développeurs doivent passer du rôle d’« exécutants de code » à celui de « décideurs techniques », orchestrant des agents d’IA pour atteindre des objectifs d’ingénierie complexes.

Dans la nouvelle normalité de Développement assisté par l'IALa mise en place d'un écosystème d'outils intelligents et complets est essentielle pour améliorer l'efficacité organisationnelle :

- Côté ingénierie et réalisation : Compter sur Codex GPT-5.2 pour résoudre des problèmes techniques complexes tels que la construction de la logique sous-jacente, l'implémentation des algorithmes et la refactorisation des systèmes existants, garantissant ainsi la robustesse de l'infrastructure technique.

- Côté gestion de la collaboration : Introduire iWeaver iWeaver sert de plateforme centrale pour les données non structurées et les flux de travail. Il gère et convertit les informations, mais décloisonne également les services. iWeaver aide les équipes techniques, ainsi que les fonctions non techniques telles que les opérations, le marketing, les ventes et la gestion de produits, à mettre en place une gestion en boucle fermée, de la conception à la réalisation. Reconnaissance des intentions et décomposition des tâches pour une allocation intelligente et un suivi de l'exécution, permettant une collaboration sans faille pour Équipes transversales.