Cos'è il GPT-5.2-Codex? In che cosa differisce dal GPT standard?

Se GPT-5.2 è un Generalista, allora GPT-5.2-Codex è un Specialista appositamente progettato per risolvere complesse sfide di programmazione.

Secondo L'ultimo post del blog di OpenAI, GPT-5.2-Codex non è semplicemente un modello GPT standard ottimizzato sui dati del codice; è il primo modello architettonicamente ottimizzato per Ingegneria end-to-end.

Differenze principali rispetto al GPT standard:

- Persistenza contestuale: I modelli GPT standard tendono a "dimenticare" le definizioni precedenti durante le conversazioni lunghe. Al contrario, il Codex possiede un'estensione ultra-lunga Finestra di contesto ottimizzato per le basi di codice, consentendogli di comprendere le dipendenze tra file.

- Esecuzione, non solo generazione: Il GPT standard eccelle nella scrittura di "frammenti di codice", mentre il GPT-5.2-Codex è progettato per comprendere un intero DepositoDurante il lancio, Sam Altman ha sottolineato che GPT-5.2-Codex non è un semplice strumento di completamento automatico; funziona come un ingegnere umano: legge la documentazione, individua i file di errore, scrive patch e supera i test, consentendo agli sviluppatori di eseguire attività all'interno di ambienti di sviluppo reali.

Punti salienti: un doppio balzo in avanti nei dati e nelle capacità

Il rilascio di GPT-5.2-Codex ha generato un acceso dibattito all'interno della comunità tecnica, incentrato principalmente su tre aree:

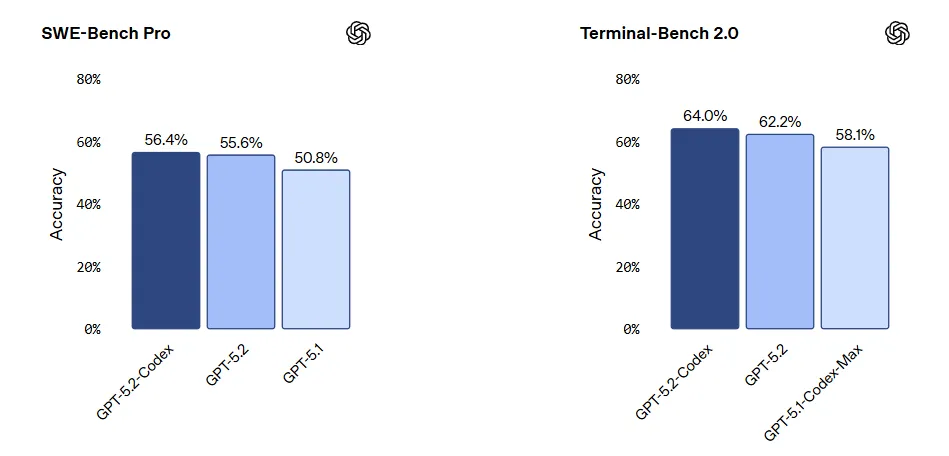

- Prestazione dominante su SWE-bench Pro: SWE-bench Pro è attualmente il gold standard per misurare le prestazioni dell'IA nella risoluzione di problemi GitHub del mondo reale. GPT-5.2-Codex ha raggiunto un punteggio storico (risolvendo oltre 60% di problemi), indicando che è andato oltre "Hello World" per risolvere bug complessi nell'ambiente di produzione.

- Ciclo di auto-miglioramento: Secondo Ars TechnicaOpenAI utilizza internamente GPT-5.2-Codex per generare dati di training e ottimizzare la propria toolchain. Questo modello di miglioramento ricorsivo "AI training AI" sta accelerando la velocità di iterazione oltre le precedenti aspettative umane.

- Robustezza per scheda di sistema: La System Card di OpenAI rivela miglioramenti significativi nella gestione delle "istruzioni ambigue". Quando i requisiti non sono chiari, il modello è meno soggetto ad allucinazioni e più incline a porre domande chiarificatrici o a ricorrere alla deduzione logica per completare il contesto.

Confronto approfondito: GPT-5.2-Codex vs. Claude Code

Un argomento spesso dibattuto sui social media è: "Qual è meglio: GPT-5.2-Codex o Claude Code?"

Li confrontiamo su tre dimensioni: dati di benchmark, esperienza utente e casi d'uso.

| Dimensione | Codice GPT-5.2 | Claude Code (3.5 Sonetto / Opus) |

| Prestazioni SWE-bench | Livello S Dimostra una schiacciante superiorità nella risoluzione di bug complessi che coinvolgono dipendenze multi-file. | Livello A Le prestazioni rimangono elevate, anche se presenta qualche difficoltà con le catene logiche molto lunghe. |

| Esperienza utente | “La Bestia della Logica” Gli utenti segnalano prestazioni impeccabili nell'architettura backend, nell'ottimizzazione degli algoritmi e nella logica matematica, con allucinazioni minime. | “Più 'umano'” In genere, gli sviluppatori ritengono che Claude dimostri una migliore "intuizione" per l'interfaccia utente frontend, l'interazione con il linguaggio naturale e la generazione di codice one-shot. |

| Stile del codice | Rigoroso e progettato Tende a generare codice di "livello aziendale" caratterizzato da commenti dettagliati e rigorosa aderenza ai modelli di progettazione. | Conciso e intuitivo Genera codice altamente leggibile, più adatto alla prototipazione rapida. |

| Integrazione dell'ecosistema | Ecosistema forte Profondamente integrato con GitHub Copilot e VS Code. | Alta flessibilità Funziona eccezionalmente bene con editor di terze parti come Cursor e Windsurf. |

Verdetto: Se il tuo obiettivo è refactoring del backend, implementazione di algoritmi o progettazione di sistemi su larga scala, GPT-5.2-Codex è la scelta ovvia. Se ti concentri su interazione frontend o prototipazione rapidaClaude Code potrebbe offrire un'esperienza superiore.

Applicazione pratica: una guida per aumentare l'efficienza della ricerca e sviluppo con GPT-5.2-Codex

Sulla base delle capacità ingegneristiche di GPT-5.2-Codex, abbiamo delineato tre scenari applicativi principali e flussi di lavoro standard all'interno del moderno ciclo di vita dello sviluppo del software (SDLC).

Scenario 1: Refactoring a livello di sistema e migrazione dello stack tecnologico

Contesto applicativo: Gestione del debito tecnico che comporta modifiche massicce ai file, come importanti aggiornamenti del framework (ad esempio, migrazione dei componenti di classe React in Hook), standardizzazione dell'infrastruttura (specifiche di registrazione, integrazione del middleware di sicurezza) e pulizia del codice morto.

Flusso di lavoro standard:

- Fase 1: Contestualizzazione del contesto. Concedi a GPT-5.2-Codex l'accesso in lettura all'intero repository Git tramite plugin IDE o strumenti di integrazione CI/CD per stabilire un indice di dipendenza completo.

- Fase 2: Definizione del vincolo. Inserire i documenti della proposta tecnica per definire i limiti del refactoring.

- Esempio di comando: "Mantenere la compatibilità con le versioni precedenti delle API V1. Tutte le operazioni del database devono passare attraverso il livello ORM; la concatenazione SQL diretta è vietata."

- Pre-elaborazione: Richiedi al modello di produrre un Piano di refactoring, elencando i moduli interessati, i potenziali rischi e le strategie di rollback.

- Fase 3: Esecuzione iterativa e Revisione.

- Esecuzione: Il modello invia richieste di pull per modulo.

- Verifica: Attiva la pipeline di test automatizzata (CI Pipeline) e invia i log degli errori al modello per la correzione automatica.

- Accettazione: Gli ingegneri umani eseguono la revisione finale del codice, concentrandosi sulla solidità architettonica piuttosto che sui dettagli della sintassi.

Scenario 2: Sviluppo a ciclo completo e debug automatizzato

Contesto applicativo: Copre lo sviluppo delle funzionalità e la correzione dei bug, con l'obiettivo di consentire all'intelligenza artificiale di gestire i dettagli di implementazione mentre gli sviluppatori si concentrano sull'orchestrazione logica.

Flusso di lavoro effettivo:

- Sviluppo di nuove funzionalità (TDD migliorato):

- Decomposizione: Inserisci il documento dei requisiti del prodotto (PRD) e fai in modo che il modello lo converta in un documento tecnico Elenco delle attività.

- Generazione del codice: Per ogni attività, richiedi al modello di generare in modo sincrono codice di implementazione aziendale E test unitari ad alta copertura.

- Correzione bug (analisi della causa principale):

- Ingresso: Fornire Stack Trace completi, frammenti di log rilevanti e file sorgente coinvolti.

- Analisi e correzione: Il modello esegue un'analisi di attribuzione tra file per individuare il Causa ultima e genera un Toppa.

- Prevenzione della regressione: Richiedere al modello di scrivere casi di test di regressione per garantire che lo stesso errore logico non si ripeta.

Guadagno di efficienza: Gli sviluppatori passano dal dedicare 80% dei loro sforzi all'implementazione del codice al concentrarsi su Chiarimento dei requisiti, Decisioni architettoniche, Recensione del caso limite, E Revisione del codice.

Scenario 3: Frontend Engineering e generazione del codice UI

Contesto applicativo: Adatto per la rapida costruzione di MVP (Minimum Viable Product), lo sviluppo di strumenti interni e il rendering ad alta fedeltà di pagine di marketing.

Flusso di lavoro standard:

Fase 1: Analisi visiva: Inserisci screenshot del design Figma o link di anteprima. GPT-5.2-Codex analizza la struttura DOM, la gerarchia dei componenti e i parametri di layout.

Fase 2: Generazione del codice:

- Strato strutturale: Genera scheletri di componenti conformi agli standard del progetto (ad esempio, React/Vue/Next.js).

- Livello di presentazione: Genera CSS atomico (ad esempio, Tailwind CSS) o il codice della libreria UI corrispondente (ad esempio, Chakra UI/Ant Design).

Fase 3: Completamento logico: Gli sviluppatori collegano i dati dell'API backend e associano gli eventi di interazione al codice generato.

Guadagno di efficienza: Riduce significativamente il tempo impiegato Codice standard, ottenendo un flusso semi-automatizzato dalla progettazione all'implementazione frontend.

Sicurezza e considerazioni pratiche

Nonostante le sue potenti capacità, la System Card di OpenAI emette degli avvertimenti che le aziende devono tenere in considerazione durante l'implementazione:

- Eccessiva sicurezza: Quando si confronta con framework privati con cui non ha familiarità, il modello potrebbe fornire con sicurezza codice errato.

- Vulnerabilità di sicurezza: Nonostante sia stato sottoposto a red-teaming, sussiste ancora il rischio di vulnerabilità di iniezione in query SQL complesse o chiamate di sistema.

- Buone pratiche: Mantenere sempre un “Umano nel ciclo” approccio. Non consentire all'intelligenza artificiale di inviare il codice direttamente in produzione; la revisione manuale del codice rimane l'ultima linea di difesa.

L'implementazione di GPT-5.2-Codex segna un cambiamento strutturale nell'ingegneria del software. Man mano che l'implementazione del codice tradizionale diventa altamente automatizzata, la competenza chiave di uno sviluppatore verrà ridefinita come Progettazione dell'architettura del sistema E Produzione tecnicaCiò significa che gli sviluppatori devono passare da "esecutori di codice" a "decision maker tecnici", orchestrando gli agenti di intelligenza artificiale per raggiungere obiettivi ingegneristici complessi.

Nella nuova normalità di Sviluppo assistito dall'intelligenza artificiale, la creazione di un ecosistema completo di strumenti intelligenti è fondamentale per migliorare l'efficienza organizzativa:

- Lato fornitura ingegneria: Affidati a Codice GPT-5.2 per risolvere problemi tecnici complessi quali la costruzione della logica di base, l'implementazione dell'algoritmo e il refactoring dei sistemi legacy, garantendo la robustezza delle basi tecniche.

- Lato gestione della collaborazione: Introdurre iWeaver come hub per dati non strutturati e flussi di lavoro. Non solo gestisce e converte le informazioni, ma colma anche i silos dipartimentali. iWeaver supporta il personale tecnico, così come i ruoli non tecnici come Operations, Marketing, Vendite e Product Manager, nel completamento della gestione a ciclo chiuso, da riconoscimento dell'intento e suddivisione delle attività in allocazione intelligente e monitoraggio dell'esecuzione, realizzando una collaborazione senza soluzione di continuità per Team interfunzionali.