Was ist GPT‐5.2‐Codex? Wie unterscheidet es sich von Standard-GPT?

Wenn GPT-5.2 ein GeneralistDann ist GPT-5.2-Codex ein Spezialist Speziell entwickelt zur Lösung komplexer Programmierherausforderungen.

Entsprechend Der neueste Blogbeitrag von OpenAIGPT-5.2-Codex ist nicht einfach nur ein Standard-GPT-Modell, das anhand von Codedaten feinabgestimmt wurde; es ist das erste architektonisch optimierte Modell für Komplette Entwicklung.

Wesentliche Unterschiede zum Standard-GPT:

- Kontextuelle Persistenz: Standard-GPT-Modelle neigen dazu, vorherige Definitionen während längerer Konversationen zu „vergessen“. Im Gegensatz dazu verfügt Codex über eine extrem lange Kontextfenster Optimiert für Codebasen, wodurch es dateiübergreifende Abhängigkeiten verstehen kann.

- Ausführung, nicht nur Generierung: Standard-GPT eignet sich hervorragend zum Schreiben von „Code-Snippets“, während GPT-5.2-Codex darauf ausgelegt ist, einen ganzen Code zu verstehen. RepositoryBei der Produkteinführung betonte Sam Altman, dass GPT-5.2-Codex kein einfaches Autocomplete-Tool sei; es funktioniere wie ein menschlicher Ingenieur – es lese Dokumentationen, lokalisiere Fehlerdateien, schreibe Patches und bestehe Tests – und ermögliche es Entwicklern, Aufgaben in realen Entwicklungsumgebungen auszuführen.

Wichtigste Highlights: Ein doppelter Sprung bei Daten und Fähigkeiten

Die Veröffentlichung des GPT-5.2-Codex hat in der technischen Gemeinschaft zu erheblichen Diskussionen geführt, die sich hauptsächlich auf drei Bereiche konzentrieren:

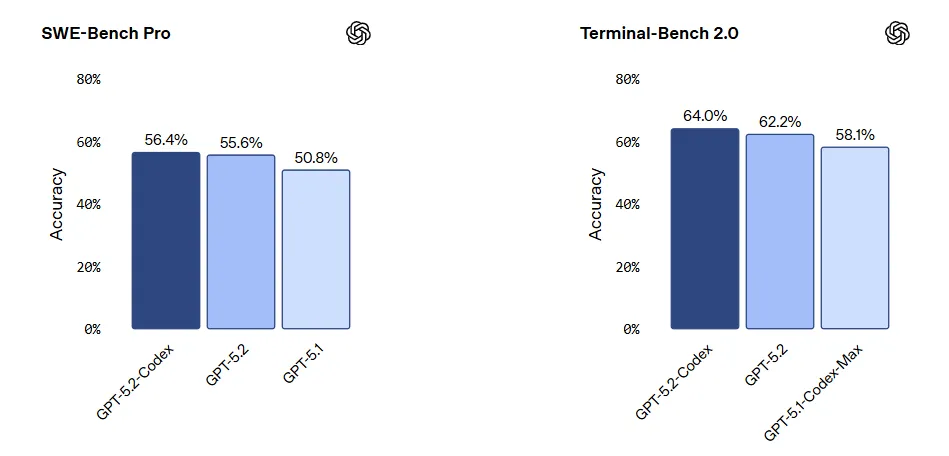

- Überragende Leistung auf SWE-bench Pro: SWE-bench Pro gilt aktuell als Goldstandard für die Messung der KI-Leistung bei der Lösung realer GitHub-Probleme. GPT-5.2-Codex erzielte einen historischen Wert (gelöste über 100 Probleme). 60% (von Problemen), was darauf hindeutet, dass es über „Hello World“ hinausgegangen ist und sich nun der Behebung komplexer Fehler in Produktionsumgebungen widmet.

- Selbstverbessernder Kreislauf: Entsprechend Ars TechnicaOpenAI verwendet intern GPT-5.2-Codex, um Trainingsdaten zu generieren und seine eigene Toolchain zu optimieren. Dieses rekursive Verbesserungsmodell, bei dem KI KI trainiert, beschleunigt die Iterationsgeschwindigkeit weit über die bisherigen menschlichen Erwartungen hinaus.

- Robustheit pro Systemkarte: Die Systemkarte von OpenAI offenbart deutliche Verbesserungen im Umgang mit „mehrdeutigen Anweisungen“. Wenn die Anforderungen unklar sind, neigt das Modell weniger zu Fehlinterpretationen und stellt eher klärende Fragen oder nutzt logische Schlussfolgerungen, um den Kontext zu vervollständigen.

Tiefgehender Vergleich: GPT-5.2-Codex vs. Claude-Code

Ein häufig diskutiertes Thema in den sozialen Medien ist: „Was ist besser: GPT-5.2-Codex oder Claude Code?“

Wir vergleichen sie anhand von drei Dimensionen: Benchmark-Daten, Benutzererfahrung und Anwendungsfälle.

| Dimension | GPT-5.2-Codex | Claude Code (3.5 Sonett / Opus) |

| SWE-Bench-Leistung | S-Tier Zeigt überragende Kompetenz bei der Behebung komplexer Fehler mit Abhängigkeiten von mehreren Dateien. | A-Tier Die Leistung bleibt gut, hat aber bei extrem langen logischen Ketten leichte Schwierigkeiten. |

| Benutzererfahrung | „Das Logik-Biest“ Nutzer berichten von einwandfreier Leistung in Bezug auf Backend-Architektur, Algorithmenoptimierung und mathematische Logik bei minimalen Halluzinationen. | „Menschlicher“ Entwickler stellen im Allgemeinen fest, dass Claude eine bessere „Intuition“ für Frontend-Benutzeroberflächen, die Interaktion in natürlicher Sprache und die einmalige Codegenerierung aufweist. |

| Code-Stil | Sorgfältig und durchdacht Genert tendenziell Code in Unternehmensqualität mit detaillierten Kommentaren und strikter Einhaltung von Entwurfsmustern. | Prägnant und intuitiv Erzeugt gut lesbaren Code, der sich besser für schnelles Prototyping eignet. |

| Ökosystemintegration | Starkes Ökosystem Tief integriert mit GitHub Copilot und VS Code. | Hohe Flexibilität Funktioniert hervorragend in Drittanbieter-Editoren wie Cursor und Windsurf. |

Urteil: Wenn Ihr Fokus darauf liegt Backend-Refactoring, Algorithmenimplementierung oder Systemdesign im großen MaßstabGPT-5.2-Codex ist die eindeutige Wahl. Wenn Sie sich auf Frontend-Interaktion oder Rapid PrototypingClaude Code bietet möglicherweise ein überlegenes Erlebnis.

Praktische Anwendung: Ein Leitfaden zur Steigerung der F&E-Effizienz mit GPT-5.2-Codex

Auf Basis der technischen Möglichkeiten des GPT-5.2-Codex haben wir drei zentrale Anwendungsszenarien und Standard-Workflows innerhalb des modernen Softwareentwicklungslebenszyklus (SDLC) skizziert.

Szenario 1: Systemweites Refactoring und Migration des Technologie-Stacks

Anwendungskontext: Management technischer Schulden im Zusammenhang mit massiven Dateiänderungen, wie z. B. größeren Framework-Upgrades (z. B. Migration von React Class Components zu Hooks), Infrastrukturstandardisierung (Protokollierungsspezifikationen, Integration von Sicherheits-Middleware) und Bereinigung von totem Code.

Standard-Arbeitsablauf:

- Schritt 1: Kontextualisierung. Gewähren Sie GPT-5.2-Codex Lesezugriff auf das gesamte Git-Repository über IDE-Plugins oder CI/CD-Integrationswerkzeuge, um einen vollständigen Abhängigkeitsindex zu erstellen.

- Schritt 2: Definition der Nebenbedingung. Eingabe technischer Angebotsdokumente zur Definition von Refactoring-Grenzen.

- Befehlsbeispiel: „Die Abwärtskompatibilität für V1-APIs muss erhalten bleiben. Alle Datenbankoperationen müssen über die ORM-Schicht erfolgen; die direkte Verkettung von SQL-Anweisungen ist untersagt.“

- Vorverarbeitung: Fordern Sie das Modell auf, ein Ergebnis auszugeben. Refactoringplan, mit Auflistung der betroffenen Module, potenzieller Risiken und Rückrufstrategien.

- Schritt 3: Iterative Ausführung & Rezension.

- Ausführung: Das Modell übermittelt Pull Requests modulweise.

- Überprüfung: Die automatisierte Testpipeline (CI-Pipeline) wird ausgelöst und Fehlerprotokolle werden zur automatischen Korrektur an das Modell zurückgesendet.

- Annahme: Menschliche Entwickler führen die abschließende Code-Überprüfung durch und konzentrieren sich dabei auf die architektonische Stimmigkeit und nicht auf Syntaxdetails.

Szenario 2: Vollständige Entwicklung und automatisiertes Debugging

Anwendungskontext: Beinhaltet Feature-Entwicklung und Fehlerbehebung mit dem Ziel, die Implementierungsdetails der KI zu überlassen, während sich die Entwickler auf die Logiksteuerung konzentrieren.

Tatsächlicher Arbeitsablauf:

- Entwicklung neuer Funktionen (Erweitertes TDD):

- Zersetzung: Geben Sie das Produktanforderungsdokument (PRD) ein und lassen Sie es vom Modell in ein technisches Dokument umwandeln. Aufgabenliste.

- Codegenerierung: Für jede Aufgabe soll das Modell synchron generiert werden. Geschäftsimplementierungscode Und Unit-Tests mit hoher Abdeckung.

- Fehlerbehebung (Ursachenanalyse):

- Eingang: Bitte stellen Sie vollständige Stack-Traces, relevante Log-Fragmente und die beteiligten Quelldateien bereit.

- Analyse & Behebung: Das Modell führt eine dateiübergreifende Zuordnungsanalyse durch, um die Grundursache und erzeugt ein Patch.

- Regressionsprävention: Das Modell soll verpflichtet werden, Regressionstestfälle zu schreiben, um sicherzustellen, dass derselbe logische Fehler nicht erneut auftritt.

Effizienzgewinn: Entwickler verlagern ihren Arbeitsaufwand von der Code-Implementierung hin zur Fokussierung auf Anforderungsklärung, Architektonische Entscheidungen, Grenzfallprüfung, Und Code-Überprüfung.

Szenario 3: Frontend-Entwicklung und UI-Code-Generierung

Anwendungskontext: Geeignet für die schnelle Erstellung eines MVP (Minimum Viable Product), die Entwicklung interner Tools und die hochauflösende Darstellung von Marketingseiten.

Standard-Arbeitsablauf:

Schritt 1: Visuelle Analyse: Figma-Design-Screenshots oder Vorschau-Links eingeben. GPT-5.2-Codex analysiert die DOM-Struktur, die Komponentenhierarchie und die Layoutparameter.

Schritt 2: Codegenerierung:

- Strukturschicht: Erzeugt Komponentenskelette, die den Projektstandards entsprechen (z. B. React/Vue/Next.js).

- Präsentationsschicht: Erzeugt atomares CSS (z. B. Tailwind CSS) oder entsprechenden UI-Bibliothekscode (z. B. Chakra UI/Ant Design).

Schritt 3: Logikvervollständigung: Entwickler verbinden Backend-API-Daten und binden Interaktionsereignisse an den generierten Code.

Effizienzgewinn: Verringert den Zeitaufwand erheblich für StandardcodeDadurch wird ein halbautomatisierter Ablauf vom Design bis zur Frontend-Implementierung erreicht.

Sicherheits- und praktische Überlegungen

Trotz ihrer leistungsstarken Funktionen gibt die Systemkarte von OpenAI Warnhinweise, die Unternehmen bei der Implementierung beachten müssen:

- Selbstüberschätzung: Beim Umgang mit unbekannten, proprietären Frameworks kann das Modell unter Umständen falschen Code liefern.

- Sicherheitslücken: Obwohl das System bereits einem Red-Teaming unterzogen wurde, besteht weiterhin das Risiko von Sicherheitslücken durch Injection in komplexen SQL-Abfragen oder Systemaufrufen.

- Bewährte Vorgehensweise: Pflegen Sie stets ein „Mensch im Regelkreis“ Vorgehensweise. KI sollte nicht direkt Code in die Produktion einspielen dürfen; die manuelle Codeüberprüfung bleibt die letzte Verteidigungslinie.

Die Einführung des GPT-5.2-Codex markiert einen Strukturwandel in der Softwareentwicklung. Da die traditionelle Code-Implementierung zunehmend automatisiert wird, wird sich die Kernkompetenz eines Entwicklers neu definieren als Systemarchitekturentwurf Und Technische ProduktisierungDies bedeutet, dass Entwickler sich von „Code-Ausführern“ zu „Technischen Entscheidungsträgern“ wandeln müssen, die KI-Agenten orchestrieren, um komplexe technische Ziele zu erreichen.

In der neuen Normalität KI-gestützte EntwicklungDer Aufbau eines umfassenden Ökosystems intelligenter Werkzeuge ist der Schlüssel zur Verbesserung der organisatorischen Effizienz:

- Technische Umsetzungsseite: Verlassen Sie sich auf GPT-5.2-Codex um komplexe technische Probleme wie die Konstruktion der zugrundeliegenden Logik, die Implementierung von Algorithmen und die Refaktorisierung von Altsystemen zu lösen und so die Robustheit der technischen Grundlage zu gewährleisten.

- Kollaborationsmanagement-Seite: Einführen iWeaver KI Als zentrale Plattform für unstrukturierte Daten und Arbeitsabläufe verwaltet und konvertiert iWeaver nicht nur Informationen, sondern überbrückt auch Abteilungsgrenzen. iWeaver unterstützt technisches Personal sowie Mitarbeiter aus nicht-technischen Bereichen wie Operations, Marketing, Vertrieb und Produktmanagement bei der Umsetzung eines geschlossenen Regelkreises. Absichtserkennung und Aufgabenaufteilung bis hin zu intelligenter Zuweisung und Ausführungsverfolgung, die eine nahtlose Zusammenarbeit ermöglicht für Funktionsübergreifende Teams.