¿Qué es GPT‑5.2‑Codex? ¿En qué se diferencia del GPT estándar?

Si GPT-5.2 es una Generalista, entonces GPT-5.2-Codex es un Especialista Diseñado específicamente para resolver desafíos de programación complejos.

De acuerdo a La última publicación del blog de OpenAIGPT-5.2-Codex no es simplemente un modelo GPT estándar ajustado a los datos del código; es el primer modelo arquitectónicamente optimizado para Ingeniería de extremo a extremo.

Diferencias principales con respecto a GPT estándar:

- Persistencia contextual: Los modelos GPT estándar tienden a olvidar definiciones previas durante conversaciones largas. En cambio, Codex posee un lenguaje ultralargo. Ventana de contexto Optimizado para bases de código, lo que le permite comprender dependencias entre archivos.

- Ejecución, no sólo generación: El GPT estándar se destaca en la escritura de "fragmentos de código", mientras que GPT-5.2-Codex está diseñado para comprender un código completo. RepositorioDurante el lanzamiento, Sam Altman enfatizó que GPT-5.2-Codex no es una simple herramienta de autocompletado; funciona como un ingeniero humano: lee documentación, localiza archivos de error, crea parches y realiza pruebas, lo que permite a los desarrolladores ejecutar tareas en entornos de desarrollo reales.

Aspectos clave: Un doble salto en datos y capacidad

El lanzamiento de GPT-5.2-Codex ha generado un debate importante dentro de la comunidad técnica, centrado principalmente en tres áreas:

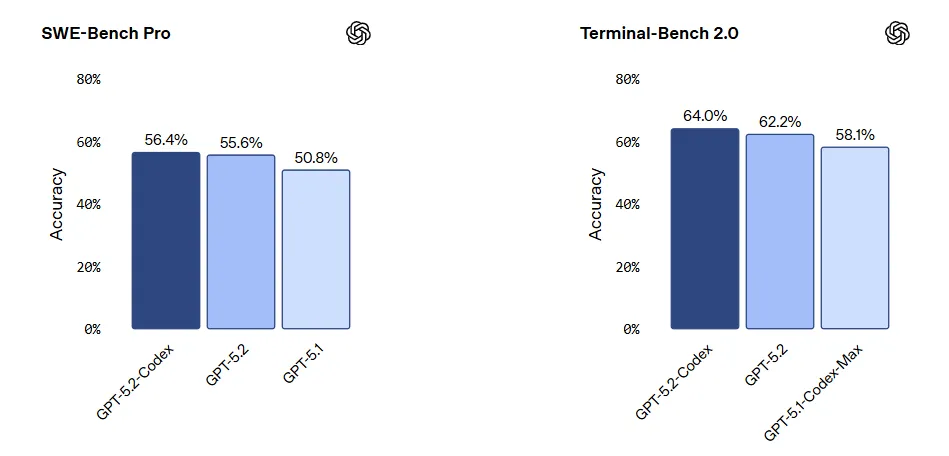

- Rendimiento dominante en SWE-bench Pro: SWE-bench Pro es actualmente el estándar de oro para medir el rendimiento de la IA en la resolución de problemas de GitHub del mundo real. GPT-5.2-Codex logró una puntuación histórica (resolviendo más de 60% de problemas), lo que indica que ha ido más allá de “Hola mundo” para corregir errores complejos del entorno de producción.

- Bucle de automejora: De acuerdo a Ars TechnicaOpenAI utiliza internamente GPT-5.2-Codex para generar datos de entrenamiento y optimizar su propia cadena de herramientas. Este modelo de mejora recursiva de «IA que entrena a IA» está acelerando la velocidad de iteración más allá de las expectativas humanas.

- Robustez por tarjeta del sistema: La Tarjeta de Sistema de OpenAI revela mejoras significativas en el manejo de instrucciones ambiguas. Cuando los requisitos no son claros, el modelo es menos propenso a las alucinaciones y más propenso a formular preguntas aclaratorias o a usar la deducción lógica para completar el contexto.

Comparación profunda: GPT-5.2-Codex vs. Claude Code

Un tema frecuentemente debatido en las redes sociales es: "¿Qué es mejor: GPT-5.2-Codex o Claude Code?"

Los comparamos en tres dimensiones: datos de referencia, experiencia del usuario y casos de uso.

| Dimensión | GPT-5.2-Códice | Claude Code (3.5 Soneto / Opus) |

| Rendimiento del banco SWE | Nivel S Demuestra un dominio abrumador en la resolución de errores complejos que involucran dependencias de múltiples archivos. | Nivel A El rendimiento sigue siendo sólido, aunque presenta algunas dificultades con cadenas lógicas ultralargas. |

| Experiencia de usuario | “La Bestia Lógica” Los usuarios informan de un rendimiento impecable en la arquitectura de backend, la optimización de algoritmos y la lógica matemática, con una mínima alucinación. | “Más 'humano'” Los desarrolladores generalmente encuentran que Claude exhibe una mejor “intuición” para la interfaz de usuario del frontend, la interacción con lenguaje natural y la generación de código de una sola vez. |

| Estilo de código | Riguroso y diseñado Tiende a generar código de “nivel empresarial” con comentarios detallados y estricta adhesión a los patrones de diseño. | Conciso e intuitivo Genera código altamente legible que es más adecuado para la creación rápida de prototipos. |

| Integración de ecosistemas | Ecosistema fuerte Profundamente integrado con GitHub Copilot y VS Code. | Alta flexibilidad Funciona excepcionalmente bien en editores de terceros como Cursor y Windsurf. |

Veredicto: Si tu enfoque es refactorización de backend, implementación de algoritmos o diseño de sistemas a gran escalaGPT-5.2-Codex es la opción más clara. Si te centras en... interacción frontend o creación rápida de prototiposClaude Code puede ofrecer una experiencia superior.

Aplicación práctica: Guía para impulsar la eficiencia de la I+D con GPT-5.2-Codex

Basándonos en las capacidades de ingeniería de GPT-5.2-Codex, hemos delineado tres escenarios de aplicación centrales y flujos de trabajo estándar dentro del ciclo de vida de desarrollo de software (SDLC) moderno.

Escenario 1: Refactorización a nivel de sistema y migración de la pila tecnológica

Contexto de aplicación: Gestión de la deuda técnica que implica cambios masivos de archivos, como actualizaciones importantes del marco (por ejemplo, migración de componentes de clase React a Hooks), estandarización de infraestructura (especificaciones de registro, integración de middleware de seguridad) y limpieza de código inactivo.

Flujo de trabajo estándar:

- Paso 1: Contextualización del contexto. Otorgue a GPT-5.2-Codex acceso de lectura a todo el repositorio Git a través de complementos IDE o herramientas de integración CI/CD para establecer un índice de dependencia completo.

- Paso 2: Definición de restricciones. Ingrese documentos de propuesta técnica para definir los límites de refactorización.

- Ejemplo de comando: Mantener la compatibilidad con versiones anteriores de las API V1. Todas las operaciones de base de datos deben pasar por la capa ORM; la concatenación directa de SQL está prohibida.

- Preprocesamiento: Solicitar al modelo que genere un Plan de refactorización, enumerando los módulos afectados, los riesgos potenciales y las estrategias de reversión.

- Paso 3: Ejecución iterativa y Revisar.

- Ejecución: El modelo envía solicitudes de extracción por módulo.

- Verificación: Active la canalización de pruebas automatizada (CI Pipeline) y envíe registros de fallas al modelo para su corrección automática.

- Aceptación: Los ingenieros humanos realizan la revisión final del código, centrándose en la solidez arquitectónica en lugar de en los detalles de sintaxis.

Escenario 2: Desarrollo de ciclo completo y depuración automatizada

Contexto de aplicación: Cubre el desarrollo de funciones y la corrección de errores, con el objetivo de permitir que la IA maneje los detalles de implementación mientras los desarrolladores se concentran en la orquestación lógica.

Flujo de trabajo real:

- Desarrollo de nuevas funciones (TDD mejorado):

- Descomposición: Ingrese el Documento de Requerimientos del Producto (PRD) y haga que el modelo lo convierta en un documento técnico. Lista de tareas.

- Generación de código: Para cada tarea, solicite al modelo que genere sincrónicamente código de implementación empresarial y pruebas unitarias de alta cobertura.

- Corrección de errores (análisis de causa raíz):

- Aporte: Proporcionar seguimientos de pila completos, fragmentos de registro relevantes y archivos fuente involucrados.

- Análisis y solución: El modelo realiza un análisis de atribución entre archivos para localizar el Causa principal y genera una Parche.

- Prevención de regresión: Exigir al modelo que escriba casos de prueba de regresión para garantizar que el mismo error lógico no se repita.

Ganancia de eficiencia: Los desarrolladores pasan de dedicar el 80% de su esfuerzo a la implementación del código a centrarse en Aclaración de requisitos, Decisiones arquitectónicas, Análisis de Edge Case, y Revisión de código.

Escenario 3: Ingeniería de frontend y generación de código de interfaz de usuario

Contexto de aplicación: Adecuado para la construcción rápida de MVP (producto mínimo viable), desarrollo de herramientas internas y representación de alta fidelidad de páginas de marketing.

Flujo de trabajo estándar:

Paso 1: Análisis visual: Ingrese capturas de pantalla del diseño de Figma o enlaces de vista previa. GPT-5.2-Codex analiza la estructura DOM, la jerarquía de componentes y los parámetros de diseño.

Paso 2: Generación de código:

- Capa de estructura: Genera esqueletos de componentes compatibles con los estándares del proyecto (por ejemplo, React/Vue/Next.js).

- Capa de presentación: Genera CSS atómico (por ejemplo, Tailwind CSS) o código de biblioteca de UI correspondiente (por ejemplo, Chakra UI/Ant Design).

Paso 3: Completar la lógica: Los desarrolladores conectan los datos de la API de backend y vinculan los eventos de interacción al código generado.

Ganancia de eficiencia: Reduce significativamente el tiempo dedicado a Código repetitivo, logrando un flujo semiautomatizado desde el diseño hasta la implementación del frontend.

Consideraciones prácticas y de seguridad

A pesar de sus potentes capacidades, la tarjeta del sistema de OpenAI emite advertencias que las empresas deben tener en cuenta durante la implementación:

- Exceso de seguridad: Cuando se enfrenta a marcos privados con los que no está familiarizado, el modelo puede proporcionar con confianza un código incorrecto.

- Vulnerabilidades de seguridad: Aunque ha sido sometido a un proceso de equipo rojo, aún existe el riesgo de vulnerabilidades de inyección en consultas SQL complejas o llamadas del sistema.

- Mejores prácticas: Mantenga siempre una “Humano en el circuito” Enfoque. No permita que la IA envíe el código directamente a producción; la revisión manual del código sigue siendo la última línea de defensa.

La implementación de GPT-5.2-Codex marca un cambio estructural en la ingeniería de software. A medida que la implementación de código tradicional se vuelve altamente automatizada, la competencia principal de un desarrollador se redefinirá como... Diseño de arquitectura de sistemas y Productividad técnicaEsto significa que los desarrolladores deben pasar de ser "ejecutores de código" a "tomadores de decisiones técnicas", orquestando agentes de IA para lograr objetivos de ingeniería complejos.

En la nueva normalidad de Desarrollo asistido por IALa construcción de un ecosistema integral de herramientas inteligentes es clave para mejorar la eficiencia organizacional:

- Lado de entrega de ingeniería: Confiar en GPT-5.2-Códice para resolver problemas técnicos difíciles como la construcción de la lógica subyacente, la implementación de algoritmos y la refactorización del sistema heredado, garantizando la solidez de la base técnica.

- Lado de gestión de la colaboración: Introducir iWeaver Como centro de datos no estructurados y flujos de trabajo. No solo gestiona y convierte información, sino que también conecta los silos departamentales. iWeaver ayuda al personal técnico, así como a los roles no técnicos como Operaciones, Marketing, Ventas y Gerentes de Producto, a completar la gestión de ciclo cerrado, desde Reconocimiento de intenciones y desglose de tareas para la asignación inteligente y el seguimiento de la ejecución, logrando una colaboración fluida para Equipos multifuncionales.