Le grand dilemme des assistants IA : un cerveau de génie enfermé dans une pièce

Nous vivons un âge d'or de l'intelligence artificielle (IA). Les grands modèles de langage (LLM) sont de véritables conseillers d'une intelligence suprême, maîtres du vaste océan de connaissances humaines.

Cependant, le fonctionnement de ce conseiller de génie présente une limite fondamentale. Imaginez qu'au lieu de collaborer côte à côte avec un collègue, vous parliez à un visiteur à travers une épaisse vitre.

Oui, vous pouvez récupérer des fichiers individuels, comme un rapport PDF, sur votre bureau et les « transférer » manuellement, un par un. Mais l'IA ne peut pas entrer proactivement dans votre bureau, consulter les discussions en temps réel sur le canal Slack de votre équipe, ni accéder et comprendre de manière autonome les connexions au sein de votre base de code locale lorsque vous en avez besoin. Elle ne possède que l'information statique et isolée que vous lui avez fournie en dernier.

Ce fossé entre les « transferts ponctuels » et la « collaboration fluide et en temps réel » constitue le principal obstacle à l'évolution de l'IA, qui passe du statut d'« outil de questions-réponses » intelligent à celui de véritable « partenaire numérique ». Ce décalage se manifeste au quotidien par de frustrantes « lacunes d'intelligence » : des failles qui naissent non pas d'un modèle insuffisamment intelligent, mais de l'absence d'un canal sécurisé et continu vers le contexte approprié.

L'IA « oublieuse »

Avez-vous déjà vécu une situation où, lors d'une longue conversation avec un assistant IA, vous insistiez à plusieurs reprises sur une contrainte de conception clé, pour finalement vous retrouver, quelques minutes plus tard, avec une solution qui l'ignorait complètement ? Ce n'est pas intentionnel ; c'est le résultat de ses « défauts de mémoire » inhérents. Des recherches ont révélé un problème appelé « Perdu au milieu“. Lorsque les modèles linguistiques traitent de longs textes, leur capacité à mémoriser des informations suit une courbe en forme de U : ils se souviennent mieux du contenu au début et à la fin, tandis que les informations coincées au milieu sont facilement négligées ou « oubliées ».Cela signifie que les informations critiques que vous avez mentionnées au milieu d'une conversation tombent directement dans l'angle mort de la mémoire du modèle, ce qui lui donne l'apparence d'un collaborateur « oublieux ».

L'IA « confuse » et « distraite »

Imaginez discuter d'un projet complexe avec un collègue constamment distrait par le brouhaha ambiant, le bruit ambiant et les sujets obsolètes. C'est précisément ce qui se produit lorsque nous transmettons à une IA un long historique de conversations non filtré. Les bavardages, les erreurs corrigées et les discussions hors sujet sont autant de « bruit » par rapport à la tâche en cours. Ce phénomène est appelé «Distraction contextuelle« Ces informations non pertinentes distraient le modèle, l'amenant à s'écarter de votre question principale et, en fin de compte, à fournir une réponse floue ou hors cible.

C'est encore pire : «Dérive contextuelleÀ mesure qu'une conversation évolue, son sujet et son objectif peuvent changer. Si l'IA ne parvient pas à reconnaître ce changement, elle risque de s'accrocher à un contexte obsolète, ce qui peut entraîner une mauvaise interprétation de votre intention. Par exemple, vous avez peut-être déjà révisé les exigences initiales, mais l'IA continue de raisonner sur la base des anciennes, ce qui aboutit à des conclusions erronées.

L'impact de ces failles techniques apparemment mineures est profond. Un partenaire oublieux, facilement distrait et qui comprend souvent mal les instructions ne peut se voir confier des responsabilités importantes. Les utilisateurs éviteront instinctivement de confier à une telle IA des tâches complexes et complexes, comme la refactorisation d'un module de code critique ou la gestion du cycle de vie d'un projet. Par conséquent, résoudre le problème de la gestion du contexte ne consiste pas seulement à améliorer la précision du modèle ; il s'agit de renforcer la confiance des utilisateurs. C'est la pierre angulaire de la construction de la prochaine génération d'agents IA autonomes (IA agentique). Ce n'est que lorsque l'IA pourra accéder au contexte et le comprendre de manière fiable et précise qu'elle pourra véritablement sortir de cette impasse et devenir un partenaire de confiance.

Découvrez MCP : le « port USB-C » pour les applications d'IA

Face au dilemme de l'IA enfermée dans des silos contextuels, l'industrie avait besoin d'une solution élégante et unifiée. En novembre 2024, Protocole de contexte modèle (MCP), dirigé par Anthropique, a été introduit. Il ne s'agit pas d'un autre modèle ou application d'IA, mais d'un cadre standardisé et open source conçu pour changer fondamentalement la façon dont l'IA se connecte au monde extérieur.

La manière la plus intuitive de comprendre le MCP est d’utiliser la métaphore largement citée : MCP est le « port USB-C » pour les applications d'IA. Pensez au monde d’avant l’USB-C : chaque appareil avait son propre chargeur et câble de données propriétaires et incompatibles, et nos tiroirs étaient remplis d’un fouillis de fils.

L'USB-C a mis fin à ce chaos en connectant tous les appareils grâce à une norme unique et unifiée. Le MCP fait de même pour l'IA. Il remplace les milliers d'« interfaces propriétaires », chacune développée sur mesure pour un outil ou une source de données spécifique, par un protocole universel, permettant à l'IA de se connecter à tout de manière « plug-and-play ».

Cette idée de standardisation n'est pas nouvelle ; son succès a des précédents. Le protocole LSP (Language Server Protocol) en est la meilleure preuve. L'émergence du LSP a permis d'intégrer facilement des fonctionnalités telles que les suggestions intelligentes et la saisie semi-automatique de code pour divers langages de programmation à tout éditeur de code, évitant ainsi aux développeurs de réinventer la roue pour chaque combinaison éditeur-langage. MCP s'appuie sur le succès du LSP et vise à reproduire cette réussite dans le domaine de l'IA.

La publication de MCP a rapidement suscité un accueil positif de la part de l'ensemble du secteur. Des géants de l'IA comme OpenAI et Google DeepMind, ainsi que des développeurs d'outils clés comme Zed et Sourcegraph, ont rapidement adopté la norme. Ce large consensus marque le début d'une tendance majeure : le secteur abandonne les efforts cloisonnés pour construire de manière collaborative un écosystème d'IA plus interconnecté.

En réfléchissant plus profondément, en concevant MCP comme un protocole ouvert L'adoption d'un produit propriétaire plutôt qu'un produit propriétaire était un choix stratégique visionnaire. Elle empêche toute entreprise de monopoliser la « couche d'intégration de l'IA », favorisant ainsi un écosystème décentralisé de concurrence et d'innovation. Cette ouverture a été essentielle à son acceptation par des concurrents comme OpenAI et Google. L'intégration de l'IA est un enjeu majeur et fragmenté, souvent qualifié de «Problème d'intégration M×N(le défi de connecter des applications d'IA M à des outils N), qu'aucune entreprise ne peut relever seule. En développant conjointement une norme ouverte, les géants collaborent pour résoudre le problème fondamental et indifférencié de la connectivité. Cela leur permet de recentrer leur compétitivité sur des domaines à plus forte valeur ajoutée : la qualité de leurs LLM de base, l'expérience utilisateur de leurs applications hôtes (comme ChatGPT vs Claude) et les capacités de leurs serveurs MCP propriétaires (comme celui fourni par GitHub pour Copilot). Cecicoopétition« Cela profite à l'ensemble du secteur : les fabricants d'outils ne sont pas limités à une seule plateforme d'IA et les utilisateurs sont libres de combiner leur IA préférée avec leurs outils préférés. Cette ouverture constitue l'avantage stratégique le plus puissant et le plus durable de MCP. »

Comment ça marche : un aperçu

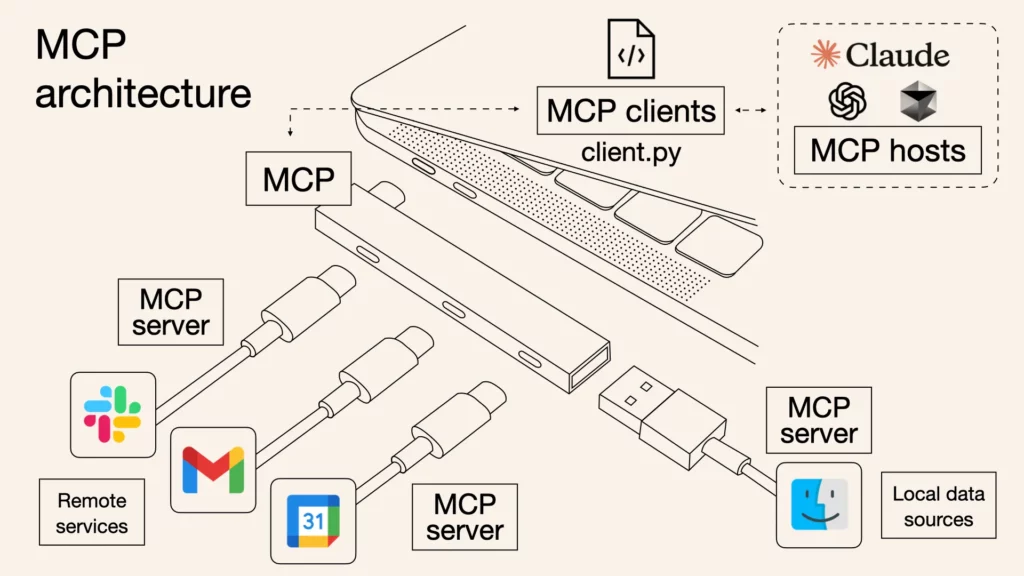

Bien que le protocole MCP soit soutenu par des spécifications techniques rigoureuses, son architecture de base peut être simplifiée en trois rôles distincts qui fonctionnent ensemble pour former un système de communication sécurisé et efficace.

- Hôte MCP : Il s'agit de l'application avec laquelle vous interagissez directement : le « cerveau » et le centre de commande de l'assistant IA. Exemples : Claude Desktop, Code VS avec l' Copilote, ou tout autre outil basé sur l'IA. L'hôte gère tout, coordonne la communication avec les différents outils et, surtout, s'assure que toute action entreprise par l'IA nécessite votre autorisation explicite.

- Client MCP : Considérez cela comme un « interprète dédié » que l'hôte attribue à chaque outil spécifique. Lorsque l'hôte souhaite interagir simultanément avec Slack et GitHub, il crée deux clients distincts et isolés. Chaque client est uniquement responsable de l'établissement d'une connexion individuelle avec son serveur désigné et utilise le protocole MCP pour la « traduction » et la communication.

- Serveur MCP : Il s'agit de l'outil ou de la source de données elle-même, désormais équipée d'un « socket » MCP. Un serveur est un programme léger qui expose les fonctionnalités de l'outil (telles que « lire un fichier », « envoyer un message » ou « interroger une base de données ») via une interface MCP standardisée que le client peut appeler.

Le flux d'informations est simple : une requête de votre part (par exemple, « Résumer le dernier rapport du dossier projet et l'envoyer sur le canal de l'équipe ») est d'abord reçue par l'hôte. Ce dernier identifie la nécessité de deux outils : le système de fichiers et Slack. Il demande ensuite le rapport au serveur du système de fichiers via le client du système de fichiers, puis envoie le résultat au serveur Slack via le client Slack, qui le publie ensuite sur le canal désigné. L'ensemble du processus de communication utilise un format standardisé appelé JSON-RPC 2.0, qui peut être interprété comme un « langage de requêtes et de réponses » structuré et compréhensible par tous les participants.

Le serveur offre principalement trois fonctionnalités : Ressources, qui sont des données que l’IA peut lire, comme un fichier ou un document ; Outils, qui sont des actions que l'IA doit exécuter, comme exécuter une commande ou appeler une API ; et Invites, qui sont des modèles d'instructions réutilisables pour simplifier les flux de travail courants.

Imaginez ceci «Hôte-Client-ServeurL'architecture est celle d'un bâtiment de haute sécurité. L'hôte (votre assistant IA) est le commandant central du bâtiment. Chaque serveur (des outils comme GitHub ou Google Drive) est comme une pièce individuelle et sécurisée au sein du bâtiment, abritant des ressources précieuses. Alors, pourquoi une couche client intermédiaire ? Imaginez que le commandant (hôte) détienne la clé principale de toutes les pièces (serveurs). Si sa clé était compromise, l'ensemble du bâtiment serait menacé. Les concepteurs de MCP ont anticipé ce problème et ne laissent donc pas le commandant ouvrir les portes directement. Au lieu de cela, le commandant engage un agent de sécurité dédié et indépendant (client) pour chaque pièce. Chaque agent ne détient que la clé de la pièce dont il est responsable.

L'intérêt de cette conception réside dans l'isolation de sécurité :

- Privilège minimum : Le garde GitHub ne peut entrer que dans la salle GitHub et n'a absolument aucun moyen d'ouvrir la porte de Google Drive.

- Maîtrise des risques : Même si la protection de Google Drive est trompée par un acteur malveillant (par exemple, si le serveur présente une vulnérabilité ou est attaqué), les dommages sont limités à la salle Google Drive. Ils n'ont aucun effet sur la salle GitHub adjacente, garantissant ainsi la sécurité des autres opérations critiques.

C'est crucial pour toute organisation. En termes simples, cela revient à diviser votre espace de travail en plusieurs compartiments indépendants et inviolables. Si un compartiment (comme un outil récemment testé) présente un problème, celui-ci y est confiné et n'affectera jamais les autres compartiments contenant vos projets principaux (comme GitHub). Vous pouvez ainsi vous connecter et expérimenter de nouveaux outils en toute confiance, sans craindre de compromettre vos workflows les plus critiques.

La voie à suivre : libérer votre IA

L'ère de l'IA confinée dans des îlots numériques touche à sa fin. Norme ouverte et unifiée, le protocole MCP (Model Context Protocol) établit un pont solide entre l'IA et le monde réel. Il ouvre la voie à un avenir nouveau, composé d'innombrables outils et fonctionnalités librement combinables et orchestrés par des agents intelligents. La question n'est plus de savoir si l'IA s'intégrera profondément à nos outils, mais comment – et le MCP apporte la réponse. Il est temps de rejoindre cette communauté florissante et de connecter votre IA à ce monde aux possibilités infinies.

Ce pont vers le monde réel a été construit, mais le voyage ne fait que commencer. Dans la deuxième partie de cette série, nous franchirons ce pont pour explorer en profondeur plusieurs cas d'utilisation concrets de MCP, explorant comment l'IA révolutionnera concrètement notre façon de travailler une fois qu'elle se sera véritablement libérée de ses chaînes contextuelles. Restez à l'écoute.

Et vous pouvez commencer avec un outil puissant dès aujourd'hui : iWeaver.

Notre service iWeaver peut être intégré comme serveur MCP, vous permettant ainsi d'intégrer ses puissantes fonctionnalités d'agent à des hôtes tels que Dify, Cursor, etc. Vous pouvez ainsi améliorer vos flux de travail existants grâce à l'intelligence unique d'iWeaver, transformant ainsi votre assistant IA de simple « génie enfermé dans une pièce » en véritable « partenaire numérique ».

Visite iWeaver.ai pour obtenir votre point de terminaison MCP et commencer à créer un assistant IA plus puissant dès aujourd'hui.