Il grande dilemma degli assistenti AI: un cervello geniale chiuso in una stanza

Viviamo in un'epoca d'oro dell'intelligenza artificiale (IA). I Large Language Models (LLM) sono come consulenti di suprema intelligenza, che dominano il vasto oceano della conoscenza umana.

Tuttavia, il modo in cui funziona questo geniale consulente ha un limite fondamentale. Immaginate di parlare con un visitatore attraverso una spessa lastra di vetro, invece di collaborare fianco a fianco con un collega.

Sì, puoi prelevare singoli file, come un report in PDF, dalla tua scrivania e "consegnarli" manualmente, uno alla volta. Ma l'IA non può entrare in modo proattivo nel tuo ufficio, vedere le discussioni in tempo reale sul canale Slack del tuo team o accedere e comprendere autonomamente le connessioni all'interno della tua base di codice locale quando ne hai bisogno. Ciò che possiede è sempre l'ultima informazione statica e isolata che le hai fornito.

Questo divario tra "conferimenti una tantum" e "collaborazione in tempo reale e senza interruzioni" è il principale ostacolo che impedisce all'IA di evolversi da uno "strumento di domande e risposte" intelligente a un vero "partner digitale". Questa discrepanza si manifesta nell'uso quotidiano sotto forma di frustranti "lacune di intelligence": difetti che emergono non perché il modello non sia abbastanza intelligente, ma perché non gli abbiamo ancora fornito un canale sicuro e continuo per raggiungere il contesto giusto.

L'intelligenza artificiale “smemorata”

Vi è mai capitato di trovarvi in una situazione in cui, durante una lunga conversazione con un assistente AI, sottolineate ripetutamente un vincolo progettuale chiave, per poi sentirvi proporre una soluzione pochi minuti dopo che lo ignora completamente? Questo non è intenzionale; è il risultato dei suoi intrinseci "difetti di memoria". La ricerca ha rivelato un problema noto come "Perso nel mezzo“. Quando i modelli linguistici elaborano testi lunghi, la loro capacità di richiamare le informazioni segue una curva a U: ricordano meglio il contenuto all’inizio e alla fine, mentre le informazioni inserite nel mezzo vengono facilmente trascurate o “dimenticate”.Ciò significa che le informazioni critiche che hai menzionato a metà conversazione rientrano esattamente nel punto cieco della memoria del modello, facendolo apparire come un collaboratore "smemorato".

L’IA “confusa” e “distratta”

Immagina di dover discutere di un progetto complesso con un collega costantemente distratto da chiacchiere, rumore irrilevante e argomenti obsoleti. Questo è esattamente ciò che accade quando forniamo a un'IA una cronologia di conversazioni lunga e non filtrata. Chiacchiere, errori corretti e discussioni fuori tema sono tutti "rumore" rispetto al compito in corso. Questo fenomeno è chiamato "Distrazione contestualeQueste informazioni irrilevanti distraggono il modello, facendolo deviare dalla domanda principale e, in definitiva, fornendo una risposta poco mirata o fuori bersaglio.

Ancora peggio è “Deriva contestualeMan mano che una conversazione si evolve, l'argomento e il focus possono cambiare. Se l'IA non riesce a riconoscere questo cambiamento, potrebbe aggrapparsi a un contesto obsoleto, portando a un'interpretazione errata delle tue intenzioni. Ad esempio, potresti aver già rivisto i requisiti iniziali, ma l'IA continua a ragionare sulla base di quelli vecchi, giungendo a conclusioni errate.

L'impatto di questi difetti tecnici apparentemente minori è profondo. A un partner smemorato, facilmente distratto e che fraintende spesso le istruzioni non possono essere affidate responsabilità significative. Gli utenti eviteranno istintivamente di affidare a un'IA di questo tipo compiti complessi e articolati in più fasi, come il refactoring di un modulo di codice critico o la gestione dell'intero ciclo di vita di un progetto. Pertanto, risolvere il problema della gestione del contesto non significa solo migliorare l'accuratezza del modello, ma anche costruire la fiducia degli utenti. È la pietra angolare per la costruzione della prossima generazione di agenti di IA autonomi (IA Agentica). Solo quando l'IA sarà in grado di accedere e comprendere il contesto in modo affidabile e accurato, potrà davvero uscire da quella stanza chiusa e diventare un partner affidabile.

Entra MCP: la “porta USB-C” per le applicazioni AI

Di fronte al dilemma dell'intelligenza artificiale intrappolata in silos contestuali, il settore necessitava di una soluzione elegante e unificata. Nel novembre 2024, Protocollo di contesto del modello (MCP), guidato da Antropico, è stato introdotto. Non si tratta di un altro modello o applicazione di intelligenza artificiale, ma di un framework standard aperto e open source progettato per cambiare radicalmente il modo in cui l'intelligenza artificiale si connette con il mondo esterno.

Il modo più intuitivo per comprendere l'MCP è attraverso la metafora ampiamente citata: MCP è la “porta USB-C” per le applicazioni AIRipensate al mondo prima dell'USB-C: ogni dispositivo aveva il suo caricabatterie e il suo cavo dati proprietari e incompatibili, e i nostri cassetti erano pieni di fili.

USB-C ha posto fine a questo caos, collegando tutti i dispositivi con un unico standard unificato. MCP fa lo stesso per il mondo dell'intelligenza artificiale. Sostituisce le migliaia di "interfacce proprietarie" – ciascuna sviluppata su misura per uno specifico strumento o fonte di dati – con un protocollo universale, consentendo all'intelligenza artificiale di connettersi a qualsiasi cosa in modalità "plug-and-play".

Questa idea di standardizzazione non è nuova; il suo successo ha precedenti. Il Language Server Protocol (LSP) ne è la prova migliore. L'emergere di LSP ha permesso di integrare facilmente funzionalità come i suggerimenti intelligenti e il completamento del codice per vari linguaggi di programmazione in qualsiasi editor di codice, evitando agli sviluppatori di dover reinventare la ruota per ogni combinazione editor-linguaggio. MCP si basa sul successo di LSP, con l'obiettivo di replicare questo risultato nel campo dell'intelligenza artificiale.

Il rilascio di MCP ha rapidamente ottenuto una risposta positiva da parte dell'intero settore. Giganti dell'intelligenza artificiale come OpenAI e Google DeepMind, così come sviluppatori di strumenti chiave come Zed e Sourcegraph, hanno rapidamente adottato lo standard. Questo ampio consenso segnala l'emergere di una tendenza importante: il settore si sta muovendo da sforzi isolati verso la costruzione collaborativa di un ecosistema di intelligenza artificiale più interconnesso.

Pensando più in profondità, progettando MCP come un protocollo aperto piuttosto che un prodotto proprietario è stata una scelta strategica visionaria. Impedisce a qualsiasi singola azienda di monopolizzare il "livello di integrazione dell'IA", promuovendo così un ecosistema decentralizzato di concorrenza e innovazione. Questa apertura è stata fondamentale per la sua accettazione da parte di concorrenti come OpenAI e Google. L'integrazione dell'IA è un problema enorme e frammentato, spesso definito "Problema di integrazione M×N(la sfida di connettere M applicazioni di intelligenza artificiale con N strumenti), che nessuna azienda può risolvere da sola. Sviluppando congiuntamente uno standard aperto, i colossi collaborano per risolvere il problema fondamentale e indifferenziato della connettività. Ciò consente loro di spostare il focus competitivo su aree di maggior valore: la qualità dei loro LLM core, l'esperienza utente delle loro applicazioni host (come ChatGPT vs. Claude) e le capacità dei loro server MCP proprietari (come quello fornito da GitHub per Copilot). Questo "co-petizione" in definitiva, avvantaggia l'intero settore: i produttori di utensili non sono vincolati a un'unica piattaforma di intelligenza artificiale e gli utenti sono liberi di combinare la loro intelligenza artificiale preferita con i loro strumenti preferiti. Questa apertura è il vantaggio strategico più potente e duraturo di MCP.

Come funziona: uno sguardo all'interno

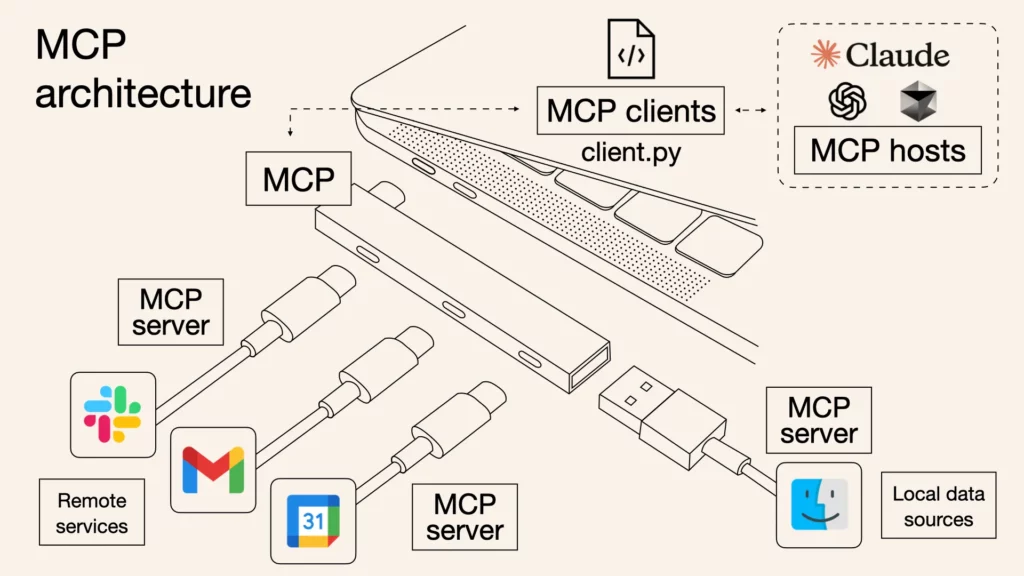

Sebbene il protocollo MCP sia supportato da rigorose specifiche tecniche, la sua architettura di base può essere semplificata in tre ruoli distinti che lavorano insieme per formare un sistema di comunicazione sicuro ed efficiente.

- Host MCP: Questa è l'applicazione con cui interagisci direttamente: il "cervello" e il centro di comando dell'assistente AI. Alcuni esempi includono Claude Desktop, Codice VS con Copiloto qualsiasi altro strumento basato sull'intelligenza artificiale. L'host gestisce tutto, coordina la comunicazione con i vari strumenti e, soprattutto, garantisce che qualsiasi azione intrapresa dall'IA richieda la tua esplicita autorizzazione.

- Cliente MCP: Consideratelo come un "interprete dedicato" che l'host assegna a ogni strumento specifico. Quando l'host desidera interagire contemporaneamente con Slack e GitHub, crea due client separati e isolati. Ogni client è responsabile solo di stabilire una connessione uno a uno con il server designato e utilizza il protocollo MCP per la "traduzione" e la comunicazione.

- Server MCP: Si tratta dello strumento o della fonte dati stessa, ora dotata di un "socket" MCP. Un server è un programma leggero che espone le funzionalità dello strumento, come "leggere un file", "inviare un messaggio" o "interrogare un database", tramite un'interfaccia MCP standardizzata che il client può chiamare.

L'intero flusso di informazioni è semplice: una richiesta da parte vostra (ad esempio, "Riepiloga l'ultimo report nella cartella del progetto e invialo al canale del team") viene innanzitutto ricevuta dall'host. L'host identifica che ciò richiede due strumenti: il file system e Slack. Quindi richiede il report al server del file system tramite il client del file system e invia il risultato al server Slack tramite il client Slack, che infine lo pubblica sul canale designato. L'intero processo di comunicazione utilizza un formato standard chiamato JSON-RPC 2.0, che può essere semplicemente inteso come un "linguaggio di richieste e risposte" strutturato e comprensibile da tutti i partecipanti.

Il server fornisce principalmente tre funzionalità: Risorse, che sono dati che l'IA deve leggere, come un file o un documento; Utensili, che sono azioni che l'IA deve eseguire, come l'esecuzione di un comando o la chiamata di un'API; e Richiede, che sono modelli di istruzioni riutilizzabili per semplificare i flussi di lavoro comuni.

Immagina questo "Host-Client-Server"architettura come un edificio ad alta sicurezza. L'Host (il tuo assistente AI) è il comandante centrale dell'edificio. Ogni Server (strumenti come GitHub o Google Drive) è come una stanza singola e sicura all'interno dell'edificio, che contiene risorse di valore. Quindi, perché avere un livello Client intermedio? Immagina se il comandante (Host) avesse una chiave maestra per tutte le stanze (Server). Se la chiave del comandante venisse compromessa, l'intero edificio sarebbe a rischio. I progettisti di MCP hanno previsto questo, quindi non permettono al comandante di aprire direttamente le porte. Invece, il comandante assume una guardia di sicurezza dedicata e indipendente (Client) per ogni stanza. Ogni guardia ha la chiave solo per la stanza di cui è responsabile.

La genialità di questo progetto risiede nell'isolamento della sicurezza:

- Privilegio minimo: La guardia di GitHub può entrare solo nella stanza di GitHub e non ha assolutamente modo di aprire la porta di Google Drive.

- Contenimento del rischio: Anche se la protezione di Google Drive viene ingannata da un malintenzionato (ad esempio, se il server presenta una vulnerabilità o viene attaccato), il danno rimane limitato alla stanza di Google Drive. Non ha alcun effetto sulla stanza GitHub adiacente, garantendo la sicurezza di altre operazioni critiche.

Questo è fondamentale per qualsiasi organizzazione. In parole povere, è come suddividere l'area di lavoro in tanti "compartimenti ignifughi" indipendenti. Se un compartimento (come uno strumento appena testato) presenta un problema, il problema rimane bloccato al suo interno e non influirà mai sugli altri compartimenti che ospitano i progetti principali (come GitHub). Pertanto, è possibile connettersi e sperimentare nuovi strumenti in tutta sicurezza, senza il timore di "bloccare" i flussi di lavoro più critici.

La strada da seguire: sbloccare la tua intelligenza artificiale

L'era dell'IA intrappolata su isole digitali sta finendo. Come standard aperto e unificato, il Model Context Protocol (MCP) sta costruendo un solido ponte tra l'IA e il mondo reale. Ciò che apre è un nuovo futuro composto da innumerevoli strumenti e capacità che possono essere liberamente combinati e orchestrati da agenti intelligenti. La domanda non è più se l'IA si integrerà profondamente con i nostri strumenti, ma come, e MCP fornisce la risposta. È tempo di unirsi a questa fiorente comunità e connettere la tua IA a questo mondo di infinite possibilità.

Questo ponte verso il mondo reale è stato costruito, ma il viaggio è solo all'inizio. Nella seconda parte di questa serie, attraverseremo questo ponte per approfondire diversi casi d'uso MCP reali, esplorando come l'IA rivoluzionerà concretamente il nostro modo di lavorare una volta che si sarà liberata completamente dalle sue catene contestuali. Rimani sintonizzato.

E oggi puoi iniziare con una cosa potente: iWeaver.

Il nostro servizio iWeaver può essere integrato come server MCP, consentendo di integrare le sue potenti funzionalità di agente in host come Dify, Cursor e altri. Ciò significa che puoi migliorare i tuoi flussi di lavoro esistenti con l'intelligenza unica di iWeaver, trasformando finalmente il tuo assistente AI da un "genio in una stanza chiusa" a un vero e proprio "partner digitale".

Visita iWeaver.ai per ottenere il tuo endpoint MCP e iniziare subito a sviluppare un assistente AI più potente.