O Grande Dilema dos Assistentes de IA: Um Cérebro Genial Preso em uma Sala

Estamos na era de ouro da inteligência artificial (IA). Os Modelos de Linguagem Ampla (MLPs) são como consultores extremamente inteligentes, dominando o vasto oceano do conhecimento humano.

No entanto, a forma como este consultor genial trabalha tem uma limitação fundamental. Imagine que, em vez de colaborar com um colega lado a lado, você está conversando com um visitante através de um painel de vidro grosso.

Sim, você pode pegar arquivos individuais, como um relatório em PDF, da sua mesa e "entregá-los" manualmente, um de cada vez. Mas a IA não pode entrar proativamente no seu escritório, ver as discussões em tempo real no canal do Slack da sua equipe ou acessar e entender de forma independente as conexões dentro da sua base de código local quando você precisar. O que ela possui é sempre a informação estática e isolada que você lhe forneceu por último.

Esse abismo entre "transferências pontuais" e "colaboração contínua e em tempo real" é o principal gargalo que impede a IA de evoluir de uma "ferramenta de perguntas e respostas" inteligente para um verdadeiro "parceiro digital". Essa desconexão se manifesta no uso diário como "lacunas de inteligência" frustrantes — falhas que surgem não porque o modelo não seja inteligente o suficiente, mas porque ainda não fornecemos a ele um canal seguro e contínuo para o contexto certo.

A IA “Esquecida”

Você já passou por uma situação em que, em uma longa conversa com um assistente de IA, você enfatiza repetidamente uma restrição importante de design, apenas para que minutos depois ele proponha uma solução que a ignora completamente? Isso não é intencional; é resultado de suas "falhas de memória" inerentes. Pesquisas revelaram um problema conhecido como "Perdido no meio“. Quando os modelos de linguagem processam textos longos, a sua capacidade de recordar informações segue uma curva em forma de U: eles lembram-se melhor do conteúdo no início e no fim, enquanto a informação intercalada no meio é facilmente ignorada ou “esquecida”.. Isso significa que as informações críticas que você mencionou no meio da conversa caem diretamente no ponto cego da memória do modelo, fazendo com que ele pareça um colaborador "esquecido".

A IA “confusa” e “distraída”

Imagine tentar discutir um projeto complexo com um colega constantemente distraído por conversas ao redor, ruídos irrelevantes e tópicos desatualizados. É exatamente isso que acontece quando alimentamos uma IA com um histórico de conversas longo e sem filtros. Conversas triviais, erros corrigidos e discussões fora do tópico são todos "ruídos" em relação à tarefa atual. Esse fenômeno é chamado de "Distração contextual“Essas informações irrelevantes distraem o modelo, fazendo com que ele se desvie da sua questão principal e, por fim, forneça uma resposta sem foco ou fora do alvo.

Pior ainda é “Deriva contextualÀ medida que uma conversa evolui, seu tópico e foco podem mudar. Se a IA não conseguir reconhecer essa mudança, ela pode se apegar a um contexto desatualizado, levando a uma interpretação equivocada da sua intenção. Por exemplo, você pode já ter revisado os requisitos iniciais, mas a IA continua a raciocinar com base nos antigos, resultando em conclusões equivocadas.

O impacto dessas falhas técnicas aparentemente insignificantes é profundo. Um parceiro que é esquecido, facilmente distraído e frequentemente interpreta mal as instruções não pode ser incumbido de responsabilidades significativas. Os usuários instintivamente evitarão que tal IA lide com tarefas complexas e multietapas, como refatorar um módulo de código crítico ou gerenciar todo o ciclo de vida de um projeto. Portanto, resolver o problema do gerenciamento de contexto não se trata apenas de melhorar a precisão do modelo; trata-se de construir a confiança do usuário. É a base para a construção da próxima geração de agentes de IA autônomos (IA Agentica). Somente quando a IA puder acessar e compreender o contexto de forma confiável e precisa, ela poderá realmente sair dessa sala trancada e se tornar nossa parceira confiável.

Apresentando o MCP: A “Porta USB-C” para Aplicações de IA

Diante do dilema da IA presa em silos contextuais, a indústria precisava de uma solução elegante e unificada. Em novembro de 2024, a Protocolo de Contexto do Modelo (MCP), liderado por Antrópico, foi introduzido. Não se trata de mais um modelo ou aplicação de IA, mas de uma estrutura padrão aberta e de código aberto, projetada para mudar fundamentalmente a forma como a IA se conecta com o mundo externo.

A maneira mais intuitiva de entender o MCP é por meio da metáfora amplamente citada: MCP é a “porta USB-C” para aplicações de IA. Pense no mundo antes do USB-C: cada dispositivo tinha seu próprio carregador e cabo de dados incompatíveis, e nossas gavetas estavam abarrotadas de fios emaranhados.

O USB-C pôs fim a esse caos, conectando todos os dispositivos com um padrão único e unificado. O MCP faz o mesmo para o mundo da IA. Ele substitui as milhares de "interfaces proprietárias" — cada uma desenvolvida sob medida para uma ferramenta ou fonte de dados específica — por um protocolo universal, permitindo que a IA se conecte a tudo de forma "plug-and-play".

Essa ideia de padronização não é nova; seu sucesso tem precedentes. O Language Server Protocol (LSP) é a melhor prova disso. O surgimento do LSP permitiu que recursos como sugestões inteligentes e complementação de código para diversas linguagens de programação fossem facilmente integrados a qualquer editor de código, poupando os desenvolvedores da necessidade de reinventar a roda para cada combinação editor-linguagem. O MCP se baseia no sucesso do LSP, com o objetivo de replicar essa conquista no domínio da IA.

O lançamento do MCP rapidamente obteve uma resposta positiva de toda a indústria. Gigantes da IA como OpenAI e Google DeepMind, bem como desenvolvedores de ferramentas importantes como Zed e Sourcegraph, adotaram rapidamente o padrão. Esse amplo consenso sinaliza a formação de uma tendência importante: a indústria está migrando de esforços isolados para a construção colaborativa de um ecossistema de IA mais interconectado.

Pensando mais profundamente, projetando o MCP como um protocolo aberto em vez de um produto proprietário, foi uma escolha estratégica visionária. Impede que uma única empresa monopolize a "camada de integração de IA", fomentando assim um ecossistema descentralizado de competição e inovação. Essa abertura foi fundamental para sua aceitação por concorrentes como OpenAI e Google. A integração de IA é uma questão enorme e fragmentada, frequentemente chamada de "Problema de integração M×N(o desafio de conectar aplicações de IA M com ferramentas N), que nenhuma empresa consegue resolver sozinha. Ao desenvolver em conjunto um padrão aberto, as gigantes estão colaborando para resolver o problema fundamental e indiferenciado da conectividade. Isso lhes permite mudar seu foco competitivo para áreas de maior valor: a qualidade de seus principais LLMs, a experiência do usuário de seus aplicativos host (como ChatGPT vs. Claude) e os recursos de seus servidores MCP primários (como o que o GitHub fornece para o Copilot). Isso "coopetição” beneficia, em última análise, toda a indústria: os fabricantes de ferramentas não ficam presos a uma única plataforma de IA, e os usuários têm a liberdade de combinar sua IA favorita com suas ferramentas preferidas. Essa abertura é a vantagem estratégica mais poderosa e duradoura da MCP.

Como funciona: uma olhada por dentro

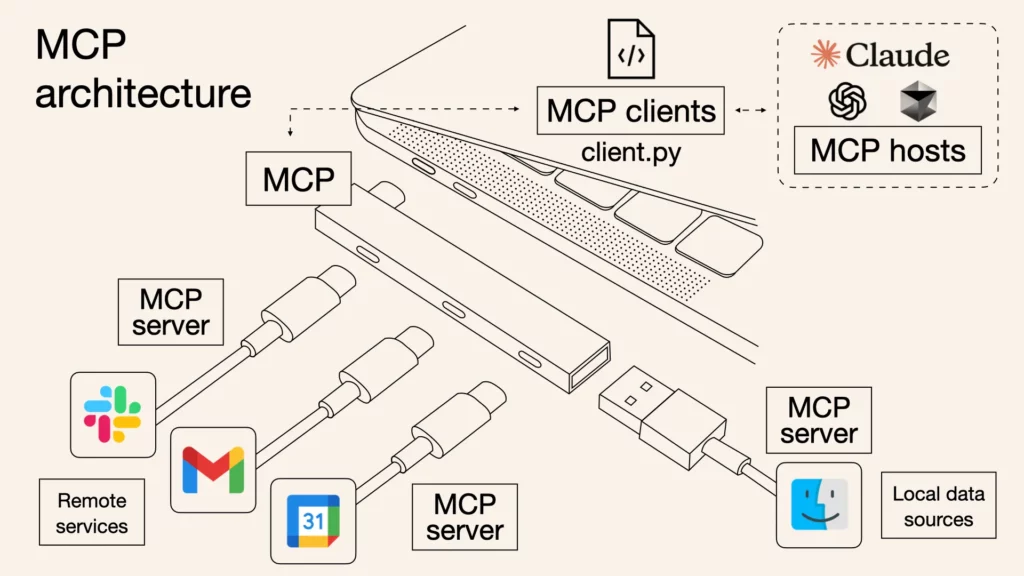

Embora o protocolo MCP seja apoiado por especificações técnicas rigorosas, sua arquitetura principal pode ser simplificada em três funções distintas que trabalham juntas para formar um sistema de comunicação seguro e eficiente.

- Anfitrião do MCP: Este é o aplicativo com o qual você interage diretamente — o "cérebro" e o centro de comando do assistente de IA. Exemplos incluem Claude Desktop, Código VS com Co-piloto, ou qualquer outra ferramenta com tecnologia de IA. O host gerencia tudo, coordena a comunicação com várias ferramentas e, o mais importante, garante que qualquer ação realizada pela IA exija sua autorização explícita.

- Cliente MCP: Pense nisso como um "interpretador dedicado" que o host atribui a cada ferramenta específica. Quando o host deseja interagir com o Slack e o GitHub simultaneamente, ele cria dois clientes separados e isolados. Cada cliente é responsável apenas por estabelecer uma conexão um-para-um com o servidor designado e usa o protocolo MCP para "tradução" e comunicação.

- Servidor MCP: Esta é a própria ferramenta ou fonte de dados, agora equipada com um "socket" MCP. Um servidor é um programa leve que expõe os recursos da ferramenta — como "ler um arquivo", "enviar uma mensagem" ou "consultar um banco de dados" — por meio de uma interface MCP padronizada para o cliente chamar.

Todo o fluxo de informações é direto: uma solicitação sua (por exemplo, "Resuma o relatório mais recente na pasta do projeto e envie para o canal da equipe") é recebida primeiro pelo host. O host identifica que isso requer duas ferramentas: o sistema de arquivos e o Slack. Em seguida, ele solicita o relatório do servidor do sistema de arquivos por meio do cliente do sistema de arquivos e envia o resultado ao servidor do Slack por meio do cliente do Slack, que finalmente o publica no canal designado. Todo o processo de comunicação utiliza um formato padronizado chamado JSON-RPC 2.0, que pode ser entendido de forma simples como uma "linguagem de solicitações e respostas" estruturada e compreensível para todos os participantes.

O servidor fornece principalmente três recursos: Recursos, que são dados para a IA ler, como um arquivo ou um documento; Ferramentas, que são ações que a IA deve executar, como executar um comando ou chamar uma API; e Avisos, que são modelos de instruções reutilizáveis para simplificar fluxos de trabalho comuns.

Imagine isso “Host-Cliente-Servidor” arquitetura como um edifício de alta segurança. O Host (seu assistente de IA) é o comandante central do edifício. Cada Servidor (ferramentas como GitHub ou Google Drive) é como uma sala individual e segura dentro do edifício, contendo ativos valiosos. Então, por que ter uma camada intermediária de Cliente? Imagine se o comandante (Host) tivesse uma chave mestra para todas as salas (Servidores). Se a chave do comandante fosse comprometida, todo o edifício estaria em risco. Os designers do MCP previram isso, então eles não deixaram o comandante abrir as portas diretamente. Em vez disso, o comandante contrata um guarda de segurança dedicado e independente (Cliente) para cada sala. Cada guarda possui apenas a chave da sala pela qual é responsável.

O brilhantismo deste design reside no isolamento de segurança:

- Menor privilégio: O guarda do GitHub só pode entrar na sala do GitHub e não tem como abrir a porta do Google Drive.

- Contenção de Riscos: Mesmo que a proteção do Google Drive seja enganada por um agente malicioso (por exemplo, se o servidor tiver uma vulnerabilidade ou for atacado), o dano se limita à sala do Google Drive. Não afeta a sala do GitHub adjacente, garantindo a segurança de outras operações críticas.

Isso é crucial para qualquer organização. Simplificando, é como dividir seu espaço de trabalho em vários "compartimentos à prova de fogo" independentes. Se um compartimento (como uma ferramenta recém-testada) apresentar um problema, o problema ficará bloqueado nele e nunca afetará os outros compartimentos que abrigam seus projetos principais (como o GitHub). Portanto, você pode se conectar e experimentar novas ferramentas com confiança, sem medo de "prejudicar" seus fluxos de trabalho mais críticos.

O caminho a seguir: desbloqueando sua IA

A era da IA presa em ilhas digitais está chegando ao fim. Como um padrão aberto e unificado, o Protocolo de Contexto do Modelo (MCP) está construindo uma ponte sólida entre a IA e o mundo real. O que ele desbloqueia é um novo futuro composto por inúmeras ferramentas e recursos que podem ser livremente combinados e orquestrados por agentes inteligentes. A questão não é mais se a IA se integrará profundamente às nossas ferramentas, mas como — e o MCP fornece a resposta. É hora de se juntar a esta comunidade próspera e conectar sua IA a este mundo de infinitas possibilidades.

Esta ponte para o mundo real já foi construída, mas a jornada está apenas começando. Na próxima Parte II desta série, cruzaremos essa ponte para nos aprofundarmos em diversos casos de uso de MCP no mundo real, explorando como a IA revolucionará concretamente a maneira como trabalhamos quando realmente se libertar de suas amarras contextuais. Fique atento.

E você pode começar com uma poderosa hoje: iWeaver.

Nosso serviço iWeaver pode ser integrado como um servidor MCP, permitindo que você leve seus poderosos recursos de agente para hosts como Dify, Cursor e outros. Isso significa que você pode aprimorar seus fluxos de trabalho existentes com a inteligência exclusiva do iWeaver, transformando finalmente seu assistente de IA de um "gênio em uma sala trancada" em um verdadeiro "parceiro digital".

Visita iWeaver.ai para obter seu endpoint MCP e começar a construir um assistente de IA mais poderoso hoje mesmo.