Das große Dilemma der KI-Assistenten: Ein geniales Gehirn, eingesperrt in einem Raum

Wir befinden uns im goldenen Zeitalter der künstlichen Intelligenz (KI). Large Language Models (LLMs) sind wie hochintelligente Berater, die den riesigen Ozean des menschlichen Wissens beherrschen.

Allerdings ist die Arbeitsweise dieses genialen Beraters mit einer grundsätzlichen Einschränkung behaftet: Stellen Sie sich vor, Sie würden nicht Seite an Seite mit einem Kollegen zusammenarbeiten, sondern durch eine dicke Glasscheibe mit einem Besucher sprechen.

Ja, Sie können einzelne Dateien, wie beispielsweise einen PDF-Bericht, von Ihrem Schreibtisch nehmen und manuell einzeln „übergeben“. Die KI kann jedoch nicht proaktiv in Ihr Büro kommen, die Echtzeitdiskussionen im Slack-Kanal Ihres Teams verfolgen oder bei Bedarf selbstständig auf die Zusammenhänge innerhalb Ihrer lokalen Codebasis zugreifen und diese verstehen. Was sie besitzt, ist immer die statische, isolierte Information, die Sie ihr zuletzt übermittelt haben.

Diese Kluft zwischen einmaligen Übergaben und nahtloser Zusammenarbeit in Echtzeit ist der zentrale Engpass, der die Entwicklung von KI von einem intelligenten „Frage-und-Antwort-Tool“ zu einem echten „digitalen Partner“ verhindert. Diese Diskrepanz manifestiert sich im täglichen Einsatz in frustrierenden „Intelligenzlücken“ – Fehler, die nicht dadurch entstehen, dass das Modell nicht intelligent genug ist, sondern dadurch, dass wir ihm noch keinen sicheren und kontinuierlichen Kanal zum richtigen Kontext bereitgestellt haben.

Die „vergessliche“ KI

Haben Sie schon einmal erlebt, dass Sie in einem langen Gespräch mit einem KI-Assistenten wiederholt eine wichtige Designbeschränkung betonen, nur um Minuten später eine Lösung vorzuschlagen, die diese völlig ignoriert? Das ist nicht beabsichtigt, sondern das Ergebnis seiner inhärenten „Gedächtnisschwächen“. Untersuchungen haben ein Problem aufgedeckt, das als „In der Mitte verloren“. Wenn Sprachmodelle lange Texte verarbeiten, folgt ihre Fähigkeit, Informationen abzurufen, einer U-förmigen Kurve: Sie erinnern sich am besten an Inhalte am Anfang und am Ende, während Informationen in der Mitte leicht übersehen oder „vergessen“ werden.Das bedeutet, dass die wichtigen Informationen, die Sie mitten im Gespräch erwähnt haben, direkt in den blinden Fleck des Modells fallen und es als „vergesslichen“ Mitarbeiter erscheinen lassen.

Die „verwirrte“ und „abgelenkte“ KI

Stellen Sie sich vor, Sie versuchen, ein komplexes Projekt mit einem Kollegen zu besprechen, der ständig von Umgebungsgesprächen, irrelevantem Lärm und veralteten Themen abgelenkt wird. Genau das passiert, wenn wir einer KI einen ungefilterten, langen Gesprächsverlauf zuführen. Smalltalk, korrigierte Fehler und Off-Topic-Diskussionen sind im Vergleich zur aktuellen Aufgabe allesamt „Lärm“. Dieses Phänomen nennt man „Kontextuelle Ablenkung„. Diese irrelevanten Informationen lenken das Modell ab, führen dazu, dass es von Ihrer Kernfrage abweicht und letztendlich eine unfokussierte oder nicht zielgerichtete Antwort liefert.

Noch schlimmer ist „Kontextuelle DriftIm Laufe eines Gesprächs können sich Thema und Fokus ändern. Wenn die KI diese Veränderung nicht erkennt, kann sie an einem veralteten Kontext festhalten, was zu einer Fehlinterpretation Ihrer Absichten führt. Beispielsweise haben Sie möglicherweise die ursprünglichen Anforderungen bereits überarbeitet, doch die KI argumentiert weiterhin auf Grundlage der alten, was zu fehlerhaften Schlussfolgerungen führt.

Die Auswirkungen dieser scheinbar kleinen technischen Mängel sind gravierend. Einem Partner, der vergesslich ist, sich leicht ablenken lässt und Anweisungen häufig missversteht, können keine bedeutenden Aufgaben anvertraut werden. Nutzer werden es instinktiv vermeiden, einer solchen KI komplexe, mehrstufige Aufgaben wie das Refactoring eines kritischen Codemoduls oder die Verwaltung des gesamten Projektlebenszyklus zu überlassen. Daher geht es bei der Lösung des Kontextmanagements nicht nur um die Verbesserung der Modellgenauigkeit, sondern auch um die Stärkung des Nutzervertrauens. Es ist der Grundstein für die Entwicklung der nächsten Generation autonomer KI-Agenten (Agentic AI). Nur wenn KI zuverlässig und präzise auf Kontext zugreifen und ihn verstehen kann, kann sie wirklich aus der Isolation heraustreten und zu unserem vertrauenswürdigen Partner werden.

MCP: Der „USB-C-Anschluss“ für KI-Anwendungen

Angesichts des Dilemmas, dass KI in kontextuellen Silos gefangen ist, benötigte die Branche eine elegante und einheitliche Lösung. Im November 2024 Modellkontextprotokoll (MCP), angeführt von Anthropisch, wurde vorgestellt. Es handelt sich nicht um ein weiteres KI-Modell oder eine weitere KI-Anwendung, sondern um ein offenes, quelloffenes Standard-Framework, das die Art und Weise, wie KI mit der Außenwelt vernetzt, grundlegend verändern soll.

Der intuitivste Weg, MCP zu verstehen, ist die häufig zitierte Metapher: MCP ist der „USB-C-Anschluss“ für KI-AnwendungenDenken Sie an die Welt vor USB-C zurück: Jedes Gerät hatte sein eigenes proprietäres, inkompatibles Ladegerät und Datenkabel und unsere Schubladen waren mit einem Kabelsalat vollgestopft.

USB-C beendete dieses Chaos und verband alle Geräte mit einem einzigen, einheitlichen Standard. MCP tut dasselbe für die Welt der KI. Es ersetzt die Tausenden von „proprietären Schnittstellen“ – jede individuell für ein bestimmtes Tool oder eine bestimmte Datenquelle entwickelt – durch ein universelles Protokoll, das es der KI ermöglicht, sich per Plug-and-Play mit allem zu verbinden.

Diese Standardisierungsidee ist nicht neu; ihr Erfolg hat Präzedenzfälle. Das Language Server Protocol (LSP) ist der beste Beweis. Dank LSP konnten Funktionen wie intelligente Vorschläge und Codevervollständigung für verschiedene Programmiersprachen problemlos in jeden Code-Editor integriert werden, sodass Entwickler nicht für jede Editor-Sprach-Kombination das Rad neu erfinden mussten. MCP baut auf dem Erfolg von LSP auf und zielt darauf ab, diesen Erfolg im KI-Bereich zu replizieren.

Die Veröffentlichung von MCP stieß in der gesamten Branche schnell auf positive Resonanz. KI-Giganten wie OpenAI und Google DeepMind sowie wichtige Tool-Entwickler wie Zed und Sourcegraph übernahmen den Standard rasch. Dieser breite Konsens signalisiert die Entstehung eines wichtigen Trends: Die Branche bewegt sich weg von isolierten Ansätzen hin zum gemeinsamen Aufbau eines stärker vernetzten KI-Ökosystems.

Tiefer denken, MCP gestalten als ein offenes Protokoll anstelle eines proprietären Produkts war eine visionäre strategische Entscheidung. Sie verhindert, dass ein einzelnes Unternehmen die „KI-Integrationsebene“ monopolisiert und fördert so ein dezentrales Ökosystem des Wettbewerbs und der Innovation. Diese Offenheit war entscheidend für die Akzeptanz bei Wettbewerbern wie OpenAI und Google. KI-Integration ist ein enormes und fragmentiertes Thema, oft als „M×N-Integrationsproblem(Die Herausforderung, M KI-Anwendungen mit N Tools zu verbinden), die kein einzelnes Unternehmen allein bewältigen kann. Durch die gemeinsame Entwicklung eines offenen Standards arbeiten die Giganten zusammen, um das grundlegende, undifferenzierte Problem der Konnektivität zu lösen. Dies ermöglicht es ihnen, ihren Wettbewerbsfokus auf höherwertige Bereiche zu verlagern: die Qualität ihrer Kern-LLMs, die Benutzerfreundlichkeit ihrer Host-Anwendungen (wie ChatGPT vs. Claude) und die Fähigkeiten ihrer First-Party-MCP-Server (wie der von GitHub für Copilot). Dies „Koopetition„Letztendlich kommt dies der gesamten Branche zugute: Werkzeughersteller sind nicht an eine einzige KI-Plattform gebunden, und Benutzer können ihre bevorzugte KI mit ihren bevorzugten Werkzeugen kombinieren. Diese Offenheit ist der stärkste und nachhaltigste strategische Vorteil von MCP.“

So funktioniert es: Ein Blick ins Innere

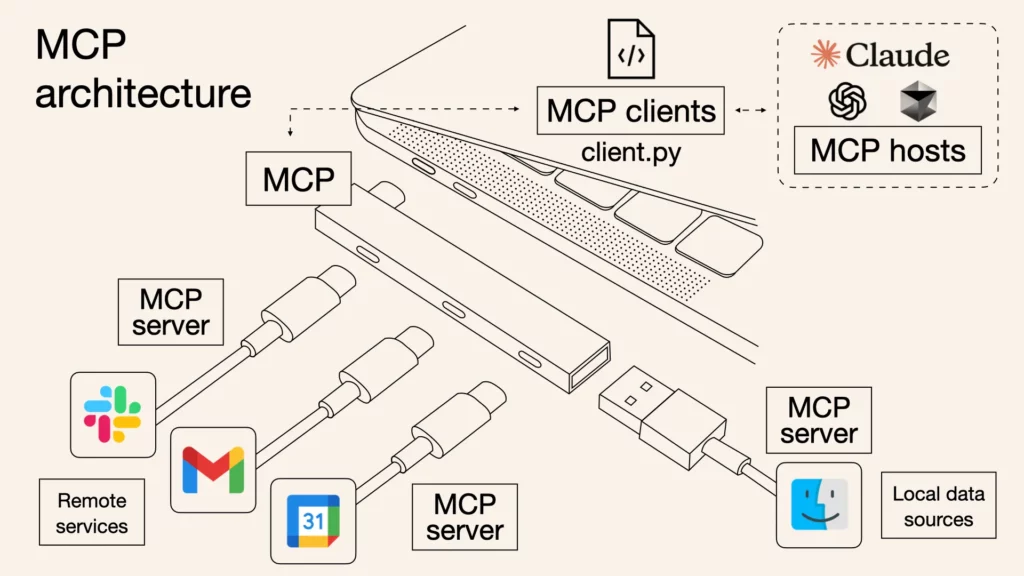

Während das MCP-Protokoll durch strenge technische Spezifikationen unterstützt wird, kann seine Kernarchitektur in drei verschiedene Rollen vereinfacht werden, die zusammenarbeiten, um ein sicheres und effizientes Kommunikationssystem zu bilden.

- MCP-Host: Dies ist die Anwendung, mit der Sie direkt interagieren – das „Gehirn“ und die Kommandozentrale des KI-Assistenten. Beispiele hierfür sind Claude Desktop, VS Code mit Kopilotoder jedes andere KI-gestützte Tool. Der Host verwaltet alles, koordiniert die Kommunikation mit verschiedenen Tools und stellt vor allem sicher, dass jede von der KI ausgeführte Aktion Ihre ausdrückliche Genehmigung erfordert.

- MCP-Client: Stellen Sie sich das wie einen dedizierten Interpreter vor, den der Host jedem Tool zuweist. Wenn der Host gleichzeitig mit Slack und GitHub interagieren möchte, erstellt er zwei separate, isolierte Clients. Jeder Client ist lediglich für den Aufbau einer 1:1-Verbindung mit seinem zugewiesenen Server verantwortlich und nutzt das MCP-Protokoll für die Übersetzung und Kommunikation.

- MCP-Server: Dabei handelt es sich um das Tool oder die Datenquelle selbst, die jetzt mit einem MCP-„Socket“ ausgestattet ist. Ein Server ist ein einfaches Programm, das die Funktionen des Tools – etwa „eine Datei lesen“, „eine Nachricht senden“ oder „eine Datenbank abfragen“ – über eine standardisierte MCP-Schnittstelle für den Aufruf durch den Client bereitstellt.

Der gesamte Informationsfluss ist unkompliziert: Ihre Anfrage (z. B. „Fassen Sie den neuesten Bericht im Projektordner zusammen und senden Sie ihn an den Team-Kanal“) wird zunächst vom Host empfangen. Der Host erkennt, dass hierfür zwei Tools erforderlich sind: das Dateisystem und Slack. Anschließend fordert er den Bericht über den Dateisystem-Client vom Dateisystem-Server an und sendet das Ergebnis über den Slack-Client an den Slack-Server, der ihn schließlich im entsprechenden Kanal veröffentlicht. Der gesamte Kommunikationsprozess verwendet ein standardisiertes Format namens JSON-RPC 2.0, das vereinfacht als strukturierte „Sprache aus Anfragen und Antworten“ verstanden werden kann, die für alle Teilnehmer verständlich ist.

Der Server bietet hauptsächlich drei Funktionen: Ressourcen, bei denen es sich um Daten handelt, die von der KI gelesen werden können, wie etwa eine Datei oder ein Dokument; Werkzeuge, bei denen es sich um Aktionen handelt, die von der KI ausgeführt werden sollen, wie etwa das Ausführen eines Befehls oder das Aufrufen einer API; und Eingabeaufforderungen, Dabei handelt es sich um wiederverwendbare Anweisungsvorlagen zur Vereinfachung gängiger Arbeitsabläufe.

Stellen Sie sich das vor „Host-Client-ServerArchitektur als Hochsicherheitsgebäude. Der Host (Ihr KI-Assistent) ist der zentrale Befehlshaber des Gebäudes. Jeder Server (Tools wie GitHub oder Google Drive) ist wie ein einzelner, sicherer Raum innerhalb des Gebäudes, der wertvolle Assets enthält. Warum also eine zwischengeschaltete Client-Ebene? Stellen Sie sich vor, der Befehlshaber (Host) hätte einen Generalschlüssel zu allen Räumen (Servern). Würde dieser Schlüssel jemals kompromittiert, wäre das gesamte Gebäude gefährdet. Die Entwickler von MCP haben dies vorausgesehen und lassen den Befehlshaber die Türen nicht direkt öffnen. Stattdessen stellt der Befehlshaber für jeden Raum einen engagierten, unabhängigen Sicherheitsbeamten (Client) ein. Jeder Sicherheitsbeamte besitzt nur den Schlüssel zu dem Raum, für den er verantwortlich ist.

Die Genialität dieses Designs liegt in der Sicherheitsisolierung:

- Geringste Privilegien: Der GitHub-Wächter kann nur den GitHub-Raum betreten und hat absolut keine Möglichkeit, die Google Drive-Tür zu öffnen.

- Risikoeindämmung: Selbst wenn der Google Drive-Schutz von einem böswilligen Akteur ausgetrickst wird (z. B. wenn der Server eine Sicherheitslücke aufweist oder angegriffen wird), bleibt der Schaden auf den Google Drive-Raum beschränkt. Der angrenzende GitHub-Raum bleibt davon unberührt, sodass die Sicherheit anderer kritischer Vorgänge gewährleistet bleibt.

Dies ist für jedes Unternehmen von entscheidender Bedeutung. Vereinfacht ausgedrückt ist es so, als würden Sie Ihren Arbeitsbereich in viele unabhängige, „feuerfeste Bereiche“ unterteilen. Tritt in einem Bereich (z. B. einem neu getesteten Tool) ein Problem auf, bleibt das Problem dort eingeschlossen und wirkt sich nicht auf die anderen Bereiche mit Ihren Kernprojekten (z. B. GitHub) aus. So können Sie sich sicher mit neuen Tools verbinden und experimentieren, ohne befürchten zu müssen, Ihre wichtigsten Workflows zu beeinträchtigen.

Der Weg nach vorn: Entfesseln Sie Ihre KI

Die Ära der digitalen Isolation von KI geht zu Ende. Als offener, einheitlicher Standard schlägt das Model Context Protocol (MCP) eine solide Brücke zwischen KI und der realen Welt. Es eröffnet eine neue Zukunft mit unzähligen Tools und Funktionen, die von intelligenten Agenten frei kombiniert und orchestriert werden können. Die Frage ist nicht mehr, ob KI sich nahtlos in unsere Tools integrieren lässt, sondern wie – und MCP liefert die Antwort. Werden Sie Teil dieser florierenden Community und verbinden Sie Ihre KI mit dieser Welt der unendlichen Möglichkeiten.

Diese Brücke zur realen Welt ist gebaut, aber die Reise beginnt gerade erst. Im kommenden Teil II dieser Serie werden wir diese Brücke überqueren, um tief in mehrere reale MCP-Anwendungsfälle einzutauchen und zu untersuchen, wie KI unsere Arbeitsweise konkret revolutionieren wird, sobald sie sich wirklich von ihren kontextuellen Fesseln löst. Bleiben Sie dran.

Und Sie können heute mit einem wirkungsvollen beginnen: iWeaver KI.

Unser iWeaver-Dienst lässt sich als MCP-Server integrieren, sodass Sie seine leistungsstarken Agentenfunktionen in Hosts wie Dify, Cursor und andere integrieren können. So können Sie Ihre bestehenden Workflows mit der einzigartigen Intelligenz von iWeaver optimieren und Ihren KI-Assistenten vom „Genie im verschlossenen Raum“ in einen echten „digitalen Partner“ verwandeln.

Besuchen iWeaver.ai um Ihren MCP-Endpunkt zu erhalten und noch heute mit der Entwicklung eines leistungsfähigeren KI-Assistenten zu beginnen.