El gran dilema de los asistentes de IA: un cerebro genial encerrado en una habitación

Nos encontramos en la era dorada de la inteligencia artificial (IA). Los Modelos de Lenguaje de Gran Tamaño (LLM) son como asesores sumamente inteligentes que dominan el vasto océano del conocimiento humano.

Sin embargo, el funcionamiento de este asesor ingenioso tiene una limitación fundamental. Imagine que, en lugar de colaborar con un colega, está hablando con un visitante a través de un grueso cristal.

Sí, puedes tomar archivos individuales, como un informe en PDF, de tu escritorio y entregarlos manualmente, uno a uno. Pero la IA no puede entrar proactivamente en tu oficina, ver las conversaciones en tiempo real en el canal de Slack de tu equipo ni acceder y comprender de forma independiente las conexiones dentro de tu código fuente local cuando lo necesites. Lo que posee siempre es la información estática y aislada que le proporcionaste por última vez.

Esta brecha entre las transferencias puntuales y la colaboración fluida en tiempo real es el principal obstáculo que impide que la IA evolucione de una herramienta inteligente de preguntas y respuestas a un verdadero socio digital. Esta desconexión se manifiesta en el uso diario como frustrantes lagunas de inteligencia: fallas que surgen no porque el modelo no sea lo suficientemente inteligente, sino porque aún no le hemos proporcionado un canal seguro y continuo hacia el contexto adecuado.

La IA “olvidadiza”

¿Alguna vez has experimentado una situación en la que, durante una larga conversación con un asistente de IA, enfatizas repetidamente una restricción clave del diseño, solo para que minutos después proponga una solución que la ignora por completo? Esto no es intencional; es el resultado de sus "fallos de memoria" inherentes. La investigación ha revelado un problema conocido como "Perdido en el medio“. Cuando los modelos de lenguaje procesan textos largos, su capacidad para recordar información sigue una curva en forma de U: recuerdan mejor el contenido al principio y al final, mientras que la información intercalada en el medio se pasa por alto o se "olvida" fácilmente.Esto significa que la información crítica que mencionaste en medio de la conversación cae directamente en el punto ciego de la memoria del modelo, lo que lo hace parecer un colaborador "olvidadizo".

La IA “confundida” y “distraída”

Imagine intentar discutir un proyecto complejo con un colega que se distrae constantemente con conversaciones, ruido irrelevante y temas obsoletos. Esto es precisamente lo que ocurre cuando alimentamos a una IA con un historial de conversaciones extenso y sin filtrar. Las conversaciones triviales, los errores corregidos y las discusiones fuera de tema son "ruido" en relación con la tarea actual. Este fenómeno se denomina "Distracción contextualEsta información irrelevante distrae al modelo, lo que hace que se desvíe de su pregunta principal y, en última instancia, proporcione una respuesta desenfocada o fuera de lugar.

Peor aún es “Deriva contextualA medida que una conversación evoluciona, su tema y enfoque pueden cambiar. Si la IA no reconoce este cambio, podría aferrarse a un contexto obsoleto, lo que llevaría a una interpretación errónea de su intención. Por ejemplo, es posible que ya haya revisado los requisitos iniciales, pero la IA sigue razonando basándose en los antiguos, lo que resulta en conclusiones erróneas.

El impacto de estas fallas técnicas aparentemente menores es profundo. A un socio olvidadizo, que se distrae con facilidad y que malinterpreta las instrucciones con frecuencia no se le pueden confiar responsabilidades importantes. Los usuarios, instintivamente, evitarán que una IA de este tipo gestione tareas complejas de varios pasos, como refactorizar un módulo de código crítico o gestionar todo el ciclo de vida de un proyecto. Por lo tanto, resolver el problema de la gestión del contexto no se trata solo de mejorar la precisión del modelo, sino de generar confianza en el usuario. Es la piedra angular para construir la próxima generación de agentes de IA autónomos (IA Agentic). Solo cuando la IA pueda acceder y comprender el contexto de forma fiable y precisa, podrá realmente salir de esa habitación cerrada y convertirse en nuestro socio de confianza.

Presentamos MCP: el «puerto USB-C» para aplicaciones de IA

Ante el dilema de que la IA se viera atrapada en silos contextuales, la industria necesitaba una solución elegante y unificada. En noviembre de 2024, Protocolo de Contexto Modelo (MCP), liderado por AntrópicoSe presentó. No se trata de otro modelo o aplicación de IA, sino de un marco estándar abierto y de código abierto diseñado para cambiar radicalmente la forma en que la IA se conecta con el mundo exterior.

La forma más intuitiva de entender el MCP es a través de la metáfora ampliamente citada: MCP es el “puerto USB-C” para aplicaciones de IAPensemos en el mundo antes del USB-C: cada dispositivo tenía su propio cargador y cable de datos propietario e incompatible, y nuestros cajones estaban repletos de un mar de cables.

USB-C puso fin a este caos, conectando todos los dispositivos con un único estándar unificado. MCP hace lo mismo en el mundo de la IA. Reemplaza las miles de interfaces propietarias —cada una diseñada a medida para una herramienta o fuente de datos específica— por un protocolo universal que permite a la IA conectarse a todo de forma "plug-and-play".

Esta idea de estandarización no es nueva; su éxito tiene precedentes. El Protocolo de Servidor de Lenguaje (LSP) es la mejor prueba de ello. La aparición del LSP permitió que funciones como las sugerencias inteligentes y la finalización de código para diversos lenguajes de programación se integraran fácilmente en cualquier editor de código, evitando así que los desarrolladores tuvieran que reinventar la rueda para cada combinación de editor y lenguaje. MCP se basa en el éxito del LSP y busca replicar este logro en el ámbito de la IA.

El lanzamiento de MCP obtuvo rápidamente una respuesta positiva de toda la industria. Gigantes de la IA como OpenAI y Google DeepMind, así como desarrolladores de herramientas clave como Zed y Sourcegraph, adoptaron rápidamente el estándar. Este amplio consenso indica el inicio de una tendencia importante: la industria está evolucionando desde esfuerzos aislados hacia la construcción colaborativa de un ecosistema de IA más interconectado.

Pensando más profundamente, diseñando MCP como un protocolo abierto En lugar de un producto propietario, fue una decisión estratégica visionaria. Impide que una sola empresa monopolice la "capa de integración de IA", fomentando así un ecosistema descentralizado de competencia e innovación. Esta apertura fue clave para su aceptación por parte de competidores como OpenAI y Google. La integración de IA es un problema enorme y fragmentado, a menudo denominado "...Problema de integración M×N(el desafío de conectar aplicaciones de IA M con herramientas N), un reto que ninguna empresa puede resolver por sí sola. Al desarrollar conjuntamente un estándar abierto, los gigantes colaboran para resolver el problema fundamental e indiferenciado de la conectividad. Esto les permite centrar su competitividad en áreas de mayor valor: la calidad de sus LLM principales, la experiencia de usuario de sus aplicaciones host (como ChatGPT frente a Claude) y las capacidades de sus servidores MCP propios (como el que GitHub proporciona para Copilot). Esto...coopeticiónEn última instancia, beneficia a toda la industria: los fabricantes de herramientas no están limitados a una única plataforma de IA, y los usuarios pueden combinar su IA favorita con sus herramientas preferidas. Esta apertura es la ventaja estratégica más poderosa y duradera de MCP.

Cómo funciona: un vistazo al interior

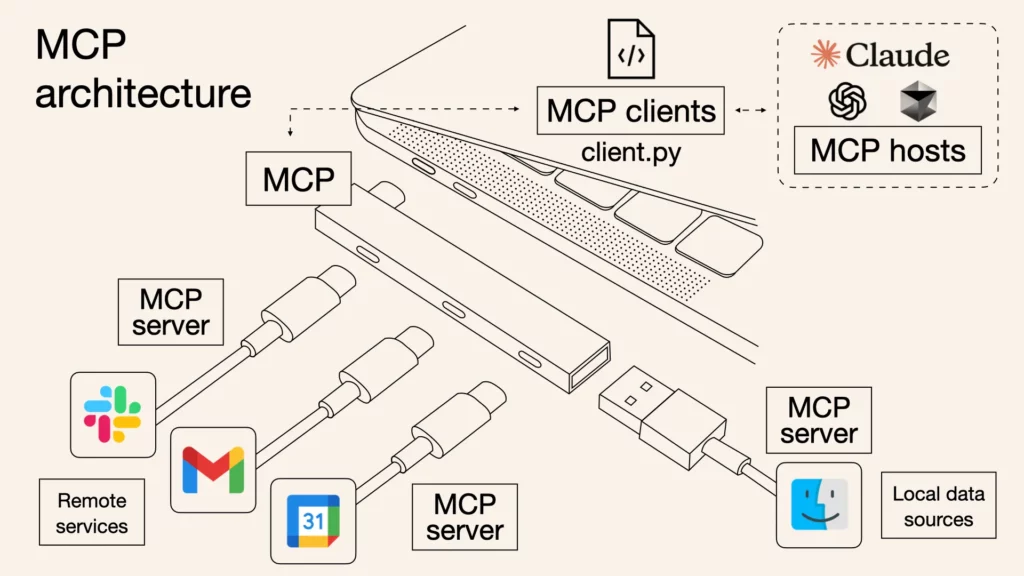

Si bien el protocolo MCP está respaldado por rigurosas especificaciones técnicas, su arquitectura central se puede simplificar en tres roles distintos que trabajan juntos para formar un sistema de comunicación seguro y eficiente.

- Anfitrión de MCP: Esta es la aplicación con la que interactúas directamente: el "cerebro" y el centro de mando del asistente de IA. Algunos ejemplos incluyen Escritorio de Claude, Código VS con Copilotoo cualquier otra herramienta impulsada por IA. El host lo gestiona todo, coordina la comunicación con diversas herramientas y, lo más importante, garantiza que cualquier acción de la IA requiera su autorización explícita.

- Cliente MCP: Piense en esto como un "intérprete dedicado" que el host asigna a cada herramienta específica. Cuando el host desea interactuar con Slack y GitHub simultáneamente, crea dos clientes separados y aislados. Cada cliente solo es responsable de establecer una conexión uno a uno con su servidor designado y utiliza el protocolo MCP para la traducción y la comunicación.

- Servidor MCP: Esta es la herramienta o fuente de datos en sí, ahora equipada con un socket MCP. Un servidor es un programa ligero que expone las capacidades de la herramienta (como leer un archivo, enviar un mensaje o consultar una base de datos) a través de una interfaz MCP estandarizada a la que el cliente puede acceder.

El flujo de información es sencillo: el host recibe primero una solicitud tuya (p. ej., "Resumir el último informe de la carpeta del proyecto y enviarlo al canal del equipo"). Este identifica que esto requiere dos herramientas: el sistema de archivos y Slack. A continuación, solicita el informe al servidor del sistema de archivos a través del cliente del sistema de archivos y envía el resultado al servidor de Slack a través del cliente de Slack, que finalmente lo publica en el canal designado. Todo el proceso de comunicación utiliza un formato estandarizado llamado JSON-RPC 2.0, que puede entenderse simplemente como un lenguaje estructurado de solicitudes y respuestas que todos los participantes pueden comprender.

El servidor proporciona principalmente tres capacidades: Recursos, que son datos que la IA debe leer, como un archivo o un documento; Herramientas, que son acciones que la IA debe ejecutar, como ejecutar un comando o llamar a una API; y Indicaciones, que son plantillas de instrucciones reutilizables para simplificar los flujos de trabajo comunes.

Imagínate esto “Host-Cliente-ServidorLa arquitectura se asemeja a la de un edificio de alta seguridad. El Host (tu asistente de IA) es el comandante central del edificio. Cada Servidor (herramientas como GitHub o Google Drive) es como una habitación individual y segura dentro del edificio, que alberga activos valiosos. Entonces, ¿por qué tener una capa intermedia de Cliente? Imagina que el comandante (Host) tuviera una llave maestra de todas las habitaciones (Servidores). Si la llave del comandante se viera comprometida, todo el edificio estaría en riesgo. Los diseñadores de MCP previeron esto, por lo que no permiten que el comandante abra las puertas directamente. En su lugar, el comandante contrata a un guardia de seguridad independiente y dedicado (Cliente) para cada habitación. Cada guardia tiene solo la llave de la habitación de la que es responsable.

La brillantez de este diseño reside en el aislamiento de seguridad:

- Mínimo privilegio: El guardia de GitHub solo puede ingresar a la sala de GitHub y no tiene forma de abrir la puerta de Google Drive.

- Contención de riesgos: Incluso si un agente malicioso engaña al sistema de seguridad de Google Drive (por ejemplo, si el servidor presenta una vulnerabilidad o es atacado), el daño se limita a la sala de Google Drive. No afecta a la sala de GitHub adyacente, lo que garantiza la seguridad de otras operaciones críticas.

Esto es crucial para cualquier organización. En pocas palabras, es como dividir tu espacio de trabajo en varios compartimentos independientes, totalmente seguros. Si un compartimento (como una herramienta recién probada) presenta un problema, este se queda dentro de él y nunca afectará a los demás compartimentos que albergan tus proyectos principales (como GitHub). Por lo tanto, puedes conectarte y experimentar con nuevas herramientas con confianza sin temor a colapsar tus flujos de trabajo más críticos.

El camino a seguir: Desbloquear su IA

La era en la que la IA se encontraba atrapada en islas digitales está llegando a su fin. Como estándar abierto y unificado, el Protocolo de Contexto de Modelo (MCP) construye un puente sólido entre la IA y el mundo real. Lo que abre es un nuevo futuro compuesto por innumerables herramientas y capacidades que agentes inteligentes pueden combinar y orquestar libremente. La pregunta ya no es si la IA se integrará plenamente con nuestras herramientas, sino cómo, y MCP ofrece la respuesta. Es hora de unirse a esta próspera comunidad y conectar su IA a este mundo de infinitas posibilidades.

Este puente hacia el mundo real ya se ha construido, pero el viaje apenas comienza. En la segunda parte de esta serie, lo cruzaremos para profundizar en varios casos prácticos de MCP en el mundo real, explorando cómo la IA revolucionará nuestra forma de trabajar una vez que se libere de sus cadenas contextuales. Manténganse al tanto.

Y puedes empezar hoy con uno poderoso: iWeaver.

Nuestro servicio iWeaver se puede integrar como servidor MCP, lo que le permite incorporar sus potentes funciones de agente a hosts como Dify, Cursor y más. Esto significa que puede optimizar sus flujos de trabajo actuales con la inteligencia única de iWeaver, transformando finalmente a su asistente de IA de un "genio en una habitación cerrada" a un verdadero "socio digital".

Visita iWeaver.ai para obtener su punto final MCP y comenzar a construir un asistente de IA más poderoso hoy.