AIアシスタントの大きなジレンマ:部屋に閉じ込められた天才脳

私たちは人工知能(AI)の黄金時代に生きています。大規模言語モデル(LLM)は、人類の知識という広大な海を支配する、まさに超知能アドバイザーのような存在です。

しかし、この天才アドバイザーの働き方には根本的な限界があります。同僚と並んで作業するのではなく、厚いガラス越しに訪問者と話しているところを想像してみてください。

確かに、PDFレポートのようなファイルをデスクから一つずつ手に取り、手作業で「渡す」ことはできます。しかし、AIはあなたのオフィスに積極的に立ち入り、チームのSlackチャンネルでリアルタイムの議論を確認したり、必要に応じてローカルコードベース内の接続に独自にアクセスして理解したりすることはできません。AIが保持するのは、常にあなたが最後に提供した静的で孤立した情報です。

「一度きりのハンドオフ」と「リアルタイムでシームレスなコラボレーション」の間のこの隔たりこそが、AIがスマートな「Q&Aツール」から真の「デジタルパートナー」へと進化するのを阻む根本的なボトルネックとなっています。この乖離は、日常的な使用において、苛立たしい「インテリジェンスギャップ」として顕在化します。これは、モデルが十分にスマートではないからではなく、適切なコンテキストへの安全で継続的なチャネルをモデルに提供できていないために生じる欠陥です。

「忘れっぽい」AI

AIアシスタントとの長い会話の中で、重要な設計上の制約を繰り返し強調したにもかかわらず、数分後にはそれを完全に無視した解決策を提案されたという経験をしたことはありませんか?これは意図的なものではなく、AIアシスタントの「記憶欠陥」によるものです。研究により、「道半ばで迷う“. 言語モデルが長いテキストを処理する場合、情報の想起能力はU字型の曲線を描きます。つまり、最初と最後の内容を最もよく記憶しますが、中間の情報は見落とされたり「忘れられ」たりしやすいのです。これは、会話の途中で言及した重要な情報がモデルの記憶の盲点に完全に落ち込んでしまい、モデルが「忘れっぽい」協力者であるように見えることを意味します。

「混乱」と「気を散らされた」AI

周囲の雑談、無関係なノイズ、そして時代遅れの話題に常に気を取られている同僚と、複雑なプロジェクトについて話し合おうとしていると想像してみてください。これはまさに、フィルタリングされていない長い会話履歴をAIに入力すると起こることです。雑談、間違いの訂正、話題から外れた議論はすべて、現在のタスクと比較すると「ノイズ」です。この現象は「文脈による注意散漫「この無関係な情報はモデルの注意をそらし、核心的な質問から逸脱させ、最終的には焦点の定まらない、あるいは的外れな回答を導き出すことになります。

さらに悪いのは「文脈の逸脱会話が進むにつれて、話題や焦点が変化する可能性があります。AIがこの変化を認識できない場合、古い文脈に固執し、ユーザーの意図を誤って解釈する可能性があります。例えば、当初の要件を既に修正しているにもかかわらず、AIは古い要件に基づいて推論を続け、誤った結論に至る可能性があります。

一見些細な技術的欠陥の影響は甚大です。忘れっぽく、注意散漫で、指示を頻繁に誤解するパートナーに、重要な責任を託すことはできません。ユーザーは、重要なコードモジュールのリファクタリングやプロジェクトのライフサイクル全体の管理といった、複雑で多段階のタスクをそのようなAIに任せることを本能的に避けるでしょう。したがって、コンテキスト管理の問題を解決することは、モデルの精度を向上させるだけでなく、ユーザーの信頼を築くことにもつながります。これは、次世代の自律型AIエージェント(エージェントAI)を構築するための基礎となります。AIが確実かつ正確にコンテキストにアクセスし、それを理解できるようになって初めて、AIは真に密室から抜け出し、信頼できるパートナーとなることができるのです。

MCPの登場: AIアプリケーションのための「USB-Cポート」

AIが文脈的なサイロに閉じ込められるというジレンマに直面し、業界は洗練された統合ソリューションを必要としていました。2024年11月、 モデルコンテキストプロトコル(MCP)、率いる 人類学的が導入されました。これは単なるAIモデルやアプリケーションではなく、AIと外部世界とのつながり方を根本的に変えるために設計された、オープンでオープンソースの標準フレームワークです。

MCP を理解する最も直感的な方法は、広く引用されている次の比喩です。 MCPはAIアプリケーション用の「USB-Cポート」ですUSB-C が登場する前の世界を思い出してください。すべてのデバイスに独自の互換性のない充電器とデータ ケーブルがあり、引き出しには無数のコードが詰め込まれていました。

USB-Cは、あらゆるデバイスを単一の統一規格で接続することで、この混乱を終わらせました。MCPはAIの世界でも同じことを実現します。MCPは、特定のツールやデータソース向けにカスタム開発された数千もの「独自仕様のインターフェース」を、汎用プロトコルに置き換え、AIがあらゆるデバイスに「プラグアンドプレイ」で接続できるようにします。

この標準化の考え方は新しいものではなく、成功例も存在します。言語サーバープロトコル(LSP)はその好例です。LSPの登場により、スマートサジェストや様々なプログラミング言語のコード補完といった機能が、あらゆるコードエディターに容易に統合できるようになり、開発者はエディターと言語の組み合わせごとに車輪の再発明をする必要がなくなりました。MCPはLSPの成功を活用し、AI分野でもこの成果を再現することを目指しています。

MCPのリリースは、業界全体からすぐに好意的な反応を得ました。OpenAIやGoogle DeepMindといったAI大手企業、そしてZedやSourcegraphといった主要ツール開発者が、この標準規格を迅速に採用しました。この幅広いコンセンサスは、業界がサイロ化された取り組みから、より相互接続されたAIエコシステムを協調的に構築する方向へと移行しつつあるという、大きなトレンドの形成を示唆しています。

より深く考え、MCPを設計する オープンプロトコル 独自製品ではなく、AI統合レイヤーを選択したことは、先見性のある戦略的選択でした。これにより、単一の企業が「AI統合レイヤー」を独占することがなくなり、競争とイノベーションの分散型エコシステムが促進されます。このオープン性こそが、OpenAIやGoogleといった競合他社に受け入れられた鍵でした。AI統合は、しばしば「M×N積分問題(M個のAIアプリケーションをN個のツールと接続するという課題)は、どの企業も単独では解決できない課題です。オープンスタンダードを共同開発することで、大手企業は接続という根本的かつ差別化されていない課題の解決に協力しています。これにより、彼らは競争上の焦点をより価値の高い領域、すなわちコアLLMの品質、ホストアプリケーションのユーザーエクスペリエンス(ChatGPTとClaudeの比較など)、そしてファーストパーティMCPサーバーの機能(GitHubがCopilotに提供しているものなど)へと移すことができます。この「競争” は最終的に業界全体に利益をもたらします。ツールメーカーは単一のAIプラットフォームに縛られることなく、ユーザーは好みのAIと好みのツールを自由に組み合わせることができます。このオープン性こそが、MCPの最も強力で永続的な戦略的優位性です。

仕組み:内部を垣間見る

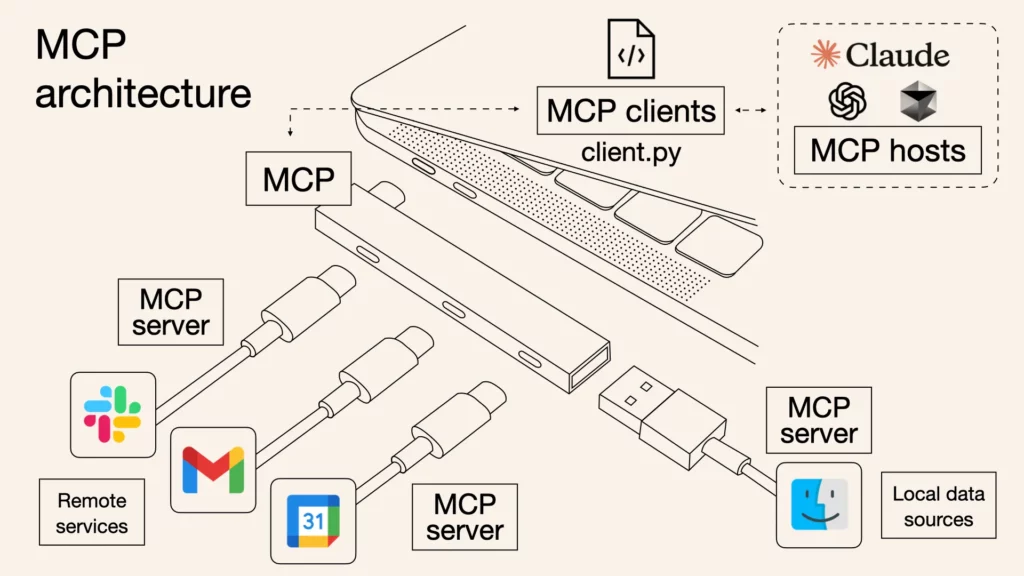

MCP プロトコルは厳格な技術仕様に基づいていますが、そのコアアーキテクチャは、安全で効率的な通信システムを形成するために連携して機能する 3 つの異なる役割に簡素化できます。

- MCPホスト: これは、ユーザーが直接操作するアプリケーションであり、AIアシスタントの「頭脳」であり、司令塔です。例としては、 クロードデスクトップ, VSコード と 副操縦士、またはその他のAI搭載ツール。ホストはすべてを管理し、さまざまなツールとの通信を調整し、そして最も重要なのは、AIが行うすべてのアクションがユーザーの明示的な承認を必要とするようにすることです。

- MCP クライアント: これは、ホストが各ツールに割り当てる「専用インタープリター」のようなものだと考えてください。ホストがSlackとGitHubの両方を同時に操作したい場合、2つの独立したクライアントを作成します。各クライアントは、指定されたサーバーとの1対1の接続を確立する役割のみを担い、MCPプロトコルを使用して「翻訳」と通信を行います。

- MCP サーバー: これは、MCP「ソケット」を備えたツールまたはデータソースそのものです。サーバーは、クライアントが呼び出す標準化されたMCPインターフェースを通じて、「ファイルの読み取り」、「メッセージの送信」、「データベースへのクエリ」などのツールの機能を公開する軽量プログラムです。

情報の流れは全体的にシンプルです。まず、ユーザーからのリクエスト(例:「プロジェクトフォルダ内の最新レポートを要約してチームチャンネルに送信してください」)がホストに送信されます。ホストは、このリクエストにはファイルシステムとSlackという2つのツールが必要であることを認識します。次に、ファイルシステムクライアントを介してファイルシステムサーバーにレポートを要求し、その結果をSlackクライアントを介してSlackサーバーに送信します。Slackサーバーは最終的にレポートを指定されたチャンネルに投稿します。この通信プロセス全体は、JSON-RPC 2.0と呼ばれる標準化されたフォーマットを使用します。これは、参加者全員が理解できる構造化された「リクエストとレスポンスの言語」と簡単に理解できます。

サーバーは主に次の 3 つの機能を提供します。 リソースファイルや文書など、AI が読み取るデータです。 ツールこれは、コマンドの実行や API の呼び出しなど、AI が実行するアクションです。 プロンプト、 一般的なワークフローを簡素化するための再利用可能な指示テンプレートです。

これを想像してみてください。ホスト-クライアント-サーバーMCP アーキテクチャは、高セキュリティの建物として機能します。ホスト (AI アシスタント) は、建物の中央司令官です。各サーバー (GitHub や Google Drive などのツール) は、建物内の個別の安全な部屋のようなもので、貴重な資産を保管しています。では、なぜ中間のクライアント層が必要なのでしょうか。司令官 (ホスト) がすべての部屋 (サーバー) のマスター キーを保持していると想像してみてください。司令官のキーが侵害された場合、建物全体が危険にさらされます。MCP の設計者はこれを予測し、司令官が直接ドアを開けないようにしています。代わりに、司令官は各部屋に専属の独立した警備員 (クライアント) を雇います。各警備員は、担当する 1 つの部屋の鍵のみを保持します。

この設計の優れた点は、セキュリティの分離にあります。

- 最小権限: GitHub ガードは GitHub ルームにしか入ることができず、Google Drive のドアを開ける方法はまったくありません。

- リスクの抑制: Google Driveガードが悪意のある攻撃者によって騙された場合でも(例:サーバーに脆弱性があったり、攻撃を受けたりした場合)、被害はGoogle Driveルーム内に限定されます。隣接するGitHubルームには影響が及ばないため、他の重要なオペレーションは安全に保護されます。

これはあらゆる組織にとって極めて重要です。簡単に言えば、ワークスペースを複数の独立した「耐火区画」に分割するようなものです。ある区画(例えば新しくテストしたツール)に問題が発生した場合、問題はその区画内に閉じ込められ、コアプロジェクト(例えばGitHub)を含む他の区画に影響を与えることはありません。そのため、最も重要なワークフローを「ダウンさせる」ことを恐れることなく、自信を持って新しいツールに接続し、実験することができます。

前進への道:AIのロックを解除する

AIがデジタルの孤島に閉じ込められていた時代は終わりを迎えています。オープンで統一された標準規格であるモデルコンテキストプロトコル(MCP)は、AIと現実世界の間に強固な橋を架けています。MCPが解き放つのは、無数のツールと機能からなる新たな未来です。これらのツールと機能は、インテリジェントエージェントによって自由に組み合わせられ、オーケストレーションされます。もはや問題は、AIが私たちのツールと深く統合されるかどうかではなく、どのように統合されるかです。そして、MCPがその答えを提供します。活気あふれるこのコミュニティに参加し、あなたのAIを無限の可能性に満ちたこの世界へと繋ぐ時が来ました。

現実世界への橋はすでに架けられていますが、旅はまだ始まったばかりです。このシリーズの第2部では、この橋を渡り、現実世界のMCPのユースケースをいくつか深く掘り下げ、AIがコンテキストの束縛から真に解放されたとき、私たちの働き方にどのような具体的な革命をもたらすのかを探ります。 乞うご期待。

そして、今日から強力なものから始めることができます: アイウィーバー.

iWeaverサービスはMCPサーバーとして統合できるため、Dify、Cursorなどのホストに強力なエージェント機能を提供できます。つまり、iWeaver独自のインテリジェンスを活用して既存のワークフローを強化し、AIアシスタントを「密室の天才」から真の「デジタルパートナー」へと変貌させることができます。

訪問 翻訳者 MCP エンドポイントを取得し、より強力な AI アシスタントの構築を今すぐ開始しましょう。